لم يعد الذكاء الاصطناعي يُظهر الإجابات على السطح فقط - بل يخلقها. وعندما تكون الإجابة خاطئة ولكنها تبدو صحيحة، تصبح المخاطر حقيقية. الميزات المهلوسة، والاستشهادات المزيفة، والآراء التي يتم تمريرها على أنها حقائق - هذا ما تواجهه العلامات التجارية والناشرون والمنصات في عصر البحث الاصطناعي. تتدخل أخلاقيات GEO Ethics في المكان الذي تقصر فيه كتب تحسين محركات البحث القديمة. لا يتعلق الأمر فقط بالعثور عليك - بل يتعلق بتمثيلك بدقة، قبل أن يختلق الذكاء الاصطناعي شيئًا ما نيابةً عنك.

الثقة والحقيقة والطبقة الخفية للبحث في الذكاء الاصطناعي

هناك مقولة - غالبًا ما ترتبط بجورج برنارد شو - تبدو وثيقة الصلة بالموضوع في الوقت الحالي: "المعرفة الزائفة أخطر من الجهل."

هذا هو أساساً ما نتجه إليه مع بحث الذكاء الاصطناعي.

عندما تجاوز عدد مستخدمي ChatGPT 100 مليون مستخدم في غضون شهرين فقط، تغيرت قواعد الإنترنت. فقد توقفت محركات البحث عن العمل كدليل سلبي وتحولت إلى شيء أقرب إلى محادثة - محادثة تولد إجابات سريعة وأحياناً أكثر ذكاءً وأحياناً أسرع وأحياناً أخرى أقل قابلية للتنبؤ.

وبالتأكيد، بدا الصوت رائعاً:

- إجابات فورية

- اكتشاف أفضل

- نتائج مصممة خصيصاً

ولكن تحت هذا السطح الأنيق، هناك شيء أكثر هشاشة يتحطم - إحساسنا المشترك بما هو حقيقي.

خذ على سبيل المثال آخر تحديث لطراز OpenAI. في الاختبارات المعيارية، هلل الإصدار o3 33% من الوقت. وهذا ضعف معدل الخطأ في النموذج السابق، o1. ونموذج o4-mini؟ كان أسوأ من ذلك، حيث أخطأ نصف الوقت تقريباً في نفس الاختبار.

وبينما تستمر هذه النماذج في التطور، يبدو أن تعقيدها يترافق مع مقايضة - المزيد من الهلوسة. وهذه مشكلة حقيقية. فكلما أصبح الذكاء الاصطناعي أكثر ذكاءً، زادت ثقته في تقديم إجابات غير صحيحة. وهذا يفرض إعادة التفكير في كيفية اختبار هذه الأنظمة وطرحها.

عندما أطلقت OpenAI برنامج GPT-5 في أغسطس 2025، صنفته على أنه قفزة كبيرة إلى الأمام. الادعاء؟ ما يصل إلى 80% هلوسة أقل من الإصدارات السابقة. قدم GPT-5 إعداداً هجيناً يقوم بالتبديل تلقائياً بين وضع الاستجابة السريعة ومسار التفكير الأعمق - والفكرة هي أن الأسئلة الأصعب تحصل على معالجة أكثر عمقاً.

و OpenAI ليس وحده في السعي وراء مخرجات أنظف. فقد كانت جوجل مشغولة بتحسين نظامها الخاص، Gemini 2.5، من خلال ميزة تسمى وضع الذكاء الاصطناعي. فبدلاً من الإجابات ذات الطلقة الواحدة، يقوم النظام بتقسيم استعلام واحد إلى عشرات الأسئلة الأصغر، ويجري عمليات بحث متوازية، ثم يجمع إجابة أكثر اكتمالاً.

ومع ذلك، تروي معايير الجهات الخارجية قصة أكثر حذرًا. حيث تضع لوحة المتصدرين في Vectara للهلوسة GPT-5 بمعدل هلوسة 1.4% - أفضل، ولكن ليس بلا عيوب تمامًا.

من المؤكد أن 1.4% تبدو أفضل على الورق من GPT-4o 1.491%، لكنها لا تزال متخلفة عن طرازات Gemini الأفضل أداءً. وهذه هي المشكلة - ما يبدو قويًا في الاختبار المعياري غالبًا ما ينهار بمجرد أن يصل إلى الاستخدام الواقعي.

هذه ليست مشكلة هامشية. فقد أصبحت الإجابات التي يتم إنشاؤها بواسطة الذكاء الاصطناعي الآن مدمجة في مليارات من عمليات البحث، وتظهر في أعلى الصفحة مباشرةً. وقد تصدرت بالفعل إجابات الذكاء الاصطناعي من Google عناوين الصحف بسبب تقديمها بثقة أخطاء فادحة - مثل القول بأن رواد الفضاء التقوا قططاً على سطح القمر، أو أننا ما زلنا نعيش في عام 2024.

قد تبدو هذه الأخطاء مضحكة في البداية، لكنها تشير إلى شيء أعمق من ذلك. عندما يتم تغليف المعلومات الخاطئة بشكل أنيق، وتقديمها بثقة، وتكرارها عبر منصات ضخمة، فإنها لا تضلل فحسب، بل تلتصق بها. هكذا يصبح التضليل أمرًا طبيعيًا.

وبالنسبة لأي شخص يعمل في تحسين محركات البحث أو المحتوى أو الاستراتيجية الرقمية، فإن هذا التحول ليس أكاديميًا. فهو يعيد تشكيل كل ما كنا نعتقد أننا نعرفه عن الرؤية.

لا يزال البحث يدور حول الملاءمة، ولكن القواعد قد تغيرت. الآن، التحدي الحقيقي هو أن تظل مرئيًا ودقيقًا - وهنا يأتي دور التحسين التوليدي للمحرك (GEO).

يعتمد GEO على نفس الأسس التي استرشد بها المحتوى الرائع لعقود: الوضوح والمصداقية والاتساق. ولكن بدلاً من تحسينه للأشخاص أو برامج زحف البحث الثابتة فقط، يتكيف GEO مع بيئة جديدة - بيئة تكون فيها النماذج اللغوية هي حراس البوابة والمفسرين، وأحيانًا حتى محرري رسالتك.

لذا فإن GEO لا يتعلق فقط بأن تتم رؤيته - بل يتعلق بأن تتم رؤيته بشكل صحيح. يتعلق الأمر ببناء محتوى يمكن للآلات التحقق منه وتمثيله وتفسيره دون تشويه المعنى.

هذا هو جوهر الأمر. لم يعد GEO مجرد استراتيجية بعد الآن. إنه حماية في مشهد البحث حيث يتم إنشاء كل من الواجهة والإجابة والسياق بشكل سريع - وعلامتك التجارية على بعد خطأ واحد فقط من سوء فهم علامتك التجارية.

ما وراء استراتيجية توقعات البيئة العالمية: نهج NUOPTIMA في نوبتيما

في نوبتيمانحن لا نكتفي بمشاهدة تطور بحث الذكاء الاصطناعي فحسب، بل نساعد في تشكيل كيفية ظهور العلامات التجارية داخله. لقد أمضى فريقنا السنوات القليلة الماضية في بناء وتنقيح نهج مدعوم بالأبحاث لتحسين المحرك التوليدي (GEO) الذي يساعد بالفعل أكثر من 70 شركة في الحصول على الاستشهاد بها مباشرةً داخل الإجابات التي يتم إنشاؤها بواسطة الذكاء الاصطناعي. وهذا يعني الظهور في المكان الأكثر أهمية - ليس فقط في الصفحة الأولى، ولكن في الإجابة.

نحن نتجاوز التصنيفات. يتمحور GEO بالنسبة لنا حول وضع المحتوى الخاص بك في أساس الاستجابة، لذلك عندما تُقدِّم أدوات مثل تقارير استعلامات الذكاء الاصطناعي من Google أو ChatGPT إجابةً، تكون علامتك التجارية جزءًا من القصة - لا أن تُستبعد منها. بدءاً من عمليات التدقيق العميق للمحتوى إلى تقارير استعلامات الذكاء الاصطناعي المُصمَّمة خصيصاً، نقوم ببناء استراتيجيات تتوافق مع كيفية معالجة النماذج اللغوية الكبيرة للمعلومات بالفعل.

إذا كنت تريد أن ترى كيف نفكر وكيف نعمل وكيف نساعد العملاء على الانتقال من الخفاء إلى الجوهر في نتائج الذكاء الاصطناعي - تواصل معنا على لينكد إن. ستجد دراسات حالة، وتفصيلات من وراء الكواليس، ومحادثات تتجاوز الكلمات الطنانة. نحن منفتحون بشأن ما تعلمناه - وما لا نزال نكتشفه.

عندما تكذب الاستشهادات: فخ المصداقية

لا يقتصر الأمر على أن نماذج الذكاء الاصطناعي تخطئ في بعض الأمور، بل إنها غالباً ما تفعل ذلك بثقة تامة، وترتدي ما يبدو وكأنه مصادر شرعية. هذه هي المشكلة الحقيقية. أنت لا تتعامل فقط مع إجابة خاطئة - أنت تتعامل مع إجابة خاطئة تبدو صحيحة.

إحدى الحالات الأكثر شهرة حدثت في عام 2024. فقد طلب برنامج Google للذكاء الاصطناعي من المستخدمين خلط "ثُمن كوب من الصمغ غير السام" في البيتزا للمساعدة على التصاق الجبن. يبدو الأمر سخيفاً - وقد كان كذلك. جاء الاقتراح مباشرةً من نكتة قديمة على موقع Reddit مدفونة في سلسلة تعليقات عمرها عقد من الزمان، لكن النظام قام بسحبها ووضعها في إطار نصيحة طبخ حقيقية.

ولم يتوقف الأمر عند هذا الحد. لقد شجعت الإجابات التي تم إنشاؤها بواسطة الذكاء الاصطناعي الناس على الاستحمام بالمحامص، وأكل الصخور الصغيرة، واتباع النصائح الطبية المجهولة التي تم كشطها من مكان مجهول.

من الأخطاء غير المؤذية إلى المخاطر التجارية

هذه الإجابات الغريبة للذكاء الاصطناعي ليست مجرد أخطاء، بل تشير إلى شيء أعمق. فالطريقة التي يتم بها تدريب النماذج اللغوية الكبيرة تعطي وزناً متساوياً لنكتة عمرها عقد من الزمن على موقع Reddit ودراسة طبية تمت مراجعتها من قبل الأقران. لا يوجد مرشح حقيقي. لا يوجد تسلسل هرمي. لذلك عندما "تستشهد" هذه الأنظمة، فإنها غالبًا ما تحاكي السلطة دون تقديم أي شيء قريب من المعلومات الموثوقة. والعواقب تتجاوز بكثير وصفات البيتزا البلهاء.

هناك مخاطر تجارية حقيقية هنا - خاصةً بالنسبة للعلامات التجارية التي لم تقم ببناء بصمة رقمية قوية. إذا لم تكن ممثلاً بشكل واضح على الإنترنت، فأنت عرضة لأن يتم تعريفك من خلال منشورات قديمة، أو منشورات على مستوى السطح، أو عمليات حفر خفية من المنافسين. لنفترض أن العلامة التجارية SaaS ليس لديها محتوى قوي من أسفل المسار. قد ينشر أحد المنافسين "مقارنة" يصورهم على أنهم غير متماسكين أو مبالغين في الأسعار. ثم يلتقط الذكاء الاصطناعي ذلك، ويكرره وكأنه إجماع، وفجأة تصبح هذه هي الرواية التي يراها المستخدمون أولاً.

عندما يخترع الذكاء الاصطناعي ما لا وجود له

إذا شقّ هذا النوع من السرد طريقه إلى شيء مثل "نظرة عامة على الذكاء الاصطناعي" من جوجل أو ردّ ChatGPT، فإنه لا يبقى مجرد سرد لمرة واحدة. بل يتم تكرارها كما لو كانت حقيقة - ليس لأنه تم التحقق منها، ولكن لأن النظام رصد نمطاً مألوفاً. وقد يأتي هذا النمط من منشور مدونة واحد، أو سلسلة تعليقات عمرها خمس سنوات، أو مراجعة سلبية بدون أي سياق. ما يبدأ كرأي يتحول بهدوء إلى إرشادات "موثوق بها" من الذكاء الاصطناعي - غالباً قبل أن يصل المستخدم إلى موقعك.

في بعض الأحيان، يصبح الأمر أكثر غرابة. فهذه النماذج لا تقوم فقط بتضخيم المدخلات المعيبة - بل تخترع أشياء من الصفر.

مثال جيد؟ بدأت شركة Soundslice، وهي منصة SaaS لتعلم الموسيقى، في تلقي تقارير أخطاء مرتبطة بشيء غريب: كان المستخدمون يقومون بتحميل علامات تبويب الغيتار ASCII بعد أن أخبرتهم شركة ChatGPT أن Soundslice يمكنها تحويلها إلى صوت. المشكلة هي أن هذه الميزة لم تكن موجودة أبداً. لقد اختلقها الذكاء الاصطناعي - وصدقها المستخدمون.

اتضح أن ChatGPT كانت تطلب من المستخدمين الاشتراك في Soundlice وتحميل علامات تبويب ASCII للحصول على تشغيل الصوت. مشكلة واحدة - هذه الميزة لم تكن موجودة. اخترعها الذكاء الاصطناعي من العدم. لذلك كان المستخدمون الآن يصلون بتوقعات لم يستطع المنتج تلبيتها، وبدا أن الشركة قد بالغت في وعودها.

وبدلاً من التراجع، انتهى الأمر بفريق Soundslice إلى بناء الميزة فقط لمواكبة الارتباك. وقد وصف مؤسس الشركة أدريان هولوفاتي هذا القرار بأنه قرار عملي - ولكنه اعترف أيضاً بأنه شعر بأن خارطة طريق المنتج قد اختطفت بسبب معلومات خاطئة.

لماذا يصبح GEO ضرورياً

هذه هي المشكلة الأكبر. عندما تبدأ إجابات الذكاء الاصطناعي في العمل كبوابة افتراضية لعلامتك التجارية، حتى أصغر تشويه يمكن أن يتفاقم. وسواء كانت معلومات قديمة، أو معلومات قديمة أو معلومات عن منافسين، أو شيء اختلقه النموذج ببساطة، فإن الخطر واحد: يتم تشويه صورة شركتك قبل أن يصل أي شخص إلى موقعك الإلكتروني.

إحدى أكبر النقاط العمياء في النماذج التوليدية هي تجاهلها التام للنية أو مصداقية المصدر أو السياق الواقعي. فهي ليست مصممة للحكم على الجودة - إنها مصممة لاكتشاف الأنماط. وهنا تبدأ الأمور في الانهيار.

- يمكن أن تبدو هذه الأنظمة موثوقة دون أن تكون دقيقة في الواقع.

- يسحبون الاستشهادات، لكنهم غالباً ما يسيئون تفسيرها.

- فهي تشير إلى بيانات حقيقية، ولكنها تسقط إخلاء المسؤولية.

- فهي تبني ردودًا تبدو مصقولة، بينما تحرف الحقيقة بهدوء.

- والأسوأ من ذلك كله - أنهم يقولون كل شيء وكأنهم متأكدون من 100%.

عندما يبدأ هذا النوع من المخرجات في إغراق نتائج البحث، يصعب تجاهل التأثيرات النهائية. يتم إساءة تمثيل العلامات التجارية. يخسر الناشرون جمهورهم. لا يستطيع مدققو الحقائق مواكبة ذلك. وكل هذا المحتوى المعيب؟ ينتهي به الأمر مرة أخرى في بيانات التدريب، مما يغذي النموذج التالي ويثبت نفس العادات السيئة - ولكن على نطاق أوسع.

هذا هو المكان الذي يتحول فيه GEO من مفيد إلى ضروري. أنت لا تحاول فقط أن تظهر علامتك التجارية بعد الآن - أنت تحاول التأكد من أن نسخة علامتك التجارية التي تظهر صحيحة بالفعل. إذا لم تقم بتشكيل المدخلات، فسيقوم النظام بتشكيل المخرجات نيابةً عنك - وربما لن تعجبك الطريقة التي ستظهر بها.

مشكلة الهلوسة لا تختفي

في الماضي عندما بدأ الذكاء الاصطناعي لأول مرة في توليد نص يبدو بشرياً، بدا الأمر وكأنه إنجاز كبير. تقدم سريعاً إلى الأمام، وهذه القوة نفسها هي الآن واحدة من أكبر نقاط ضعفه. ما يسميه الباحثون بأدب "الهلوسة" هو، بعبارات واضحة، أخطاء واثقة - إجابات خاطئة تبدو صحيحة وتنتشر بسرعة.

الجزء الأسوأ؟ لا تبدو هذه المخرجات قابلة للتصديق فقط - فهي غالبًا ما تحاكي نبرة المعلومات الحقيقية وهيكلها وسلطتها على المستوى السطحي. تبدو مألوفة. من الصعب التحقق من صحتها بشكل سريع. وهذا يجعلها خطيرة بشكل خاص.

التبعات القانونية والطبية

إنها ليست مشكلة هامشية أيضاً. فقد وجدت دراسة مشتركة من جامعة ستانفورد ومجموعات أكاديمية أخرى أن أدوات البحث القانوني المدعومة بالذكاء الاصطناعي - بما في ذلك من الشركات الكبرى مثل LexisNexis وTomson Reuters - قد هلوست في ما يتراوح بين 171 تيرابايت إلى 331 تيرابايت من ردودها.

في العالم القانوني، تظهر هذه الهلوسة بطريقتين خطيرتين - إما أن يذكر الذكاء الاصطناعي القانون بشكل خاطئ تمامًا، أو أنه يستشهد بقاعدة شرعية ولكنه يرفق المصدر الخاطئ. وهذا النوع الثاني قد يكون أسوأ، لأنه يضلل المستخدمين الذين يعتمدون على النظام لتوجيههم إلى شيء موثوق به.

الرعاية الصحية ليست محصنة أيضًا. حتى مع النماذج المدربة تدريباً عالياً، يمكن أن تتراوح معدلات الهلوسة في الاستشهادات الطبية في أي مكان من 28% وصولاً إلى 90%، اعتماداً على المهمة. قد لا يبدو ذلك مقلقاً للوهلة الأولى - إلى أن تتذكر أن هذه الأنظمة تقوم بإرسال مليارات الاستفسارات. على نطاق واسع، تتحول معدلات الخطأ "البسيطة" هذه إلى عشرات الملايين من النتائج المضللة أو حتى الضارة كل يوم.

الهلوسة في نتائج البحث

ولم يعد هذا الأمر محصوراً في حالات الحافة بعد الآن. فقد أصبحت إجابات الذكاء الاصطناعي الآن مدمجة في البحث السائد. فمع ظهور المزيد من المحتوى الذي يتم إنشاؤه بواسطة الذكاء الاصطناعي مباشرةً في نتائج البحث على محرك البحث، أصبحت هذه الهلوسة جزءاً من التجربة الافتراضية للمستخدمين العاديين.

في شهر مارس 2025، أظهرت بيانات Semrush أن 13.141 تيرابايت من جميع استعلامات Google أثارت نظرة عامة على الذكاء الاصطناعي - أي ضعف المعدل الذي كان عليه قبل شهرين فقط. كان الارتفاع أكثر حدة في المجالات الأكثر حساسية: الرعاية الصحية، والقانون، والحكومة، والعلوم، والمواضيع الاجتماعية. الأماكن التي لا يمكن أن تنزلق فيها الدقة حقًا.

لماذا تتزايد المخاطر

على حد تعبير محلل Semrush، إنها خطوة جريئة من Google أن تطرح Google نظرة عامة على الذكاء الاصطناعي بهذه القوة في قطاعات مثل الصحة والقانون والعلوم - وهي مجالات غالباً ما تكون الإجابات فيها محل خلاف وهامش الخطأ فيها ضئيل. هذه هي القطاعات التي تعاني بالفعل من المعلومات المضللة وتحمل أعباءً تنظيمية ثقيلة.

قد تعتقد Google أن النماذج دقيقة بما فيه الكفاية. ولكن الواقع أكثر تعقيداً. فمع بدء المزيد من المستخدمين في الوثوق بالملخصات التي يتم إنشاؤها بواسطة الذكاء الاصطناعي دون سؤال، تزداد احتمالية انتشار المعلومات السيئة بسرعة - وعلى نطاق واسع.

هذا يضعنا في موقف صعب

بُنيت مُحسّنات محرّكات البحث التقليدية على الملاءمة والمصداقية والإشارات الواضحة للسلطة. ولكن النتائج التي يتم إنشاؤها بالذكاء الاصطناعي غالبًا ما تعيد مزج المحتوى بطرق تطمس السياق أو تغفل الهدف الأصلي تمامًا.

ربما لا يزال يتم الاستشهاد بك - ولكن ليس بالطريقة التي تريدها. ربما تظهر علامتك التجارية في الإخراج، لكن الإطار غير صحيح، أو أن الحقائق الأساسية مشوهة. وبمجرد وصول هذه النسخة إلى الصفحة، تصبح النسخة الافتراضية الجديدة لأي شخص يراها.

وهنا يأتي دور GEO. إنه ليس حلاً سحرياً للهلوسة، ولكنه وسيلة لتقليل الضرر. يتعلق GEO بأن تكون متعمدًا - باستخدام الهيكل والوضوح والإشارات الواقعية لتوجيه أنظمة الذكاء الاصطناعي نحو التفسير الصحيح للمحتوى الخاص بك، وليس التفسير المشوه.

من الناحية العملية، يمكن أن يبدو ذلك على النحو التالي

- كتابة المحتوى الذي يجعل القصد منه واضحًا وضوح الشمس - لا غموض ولا مجال لسوء التفسير

- دعم النقاط الرئيسية بإشارات وقائعية قوية مثل الاستشهادات الموثوقة والبيانات المهيكلة والكيانات الموسومة بشكل صحيح

- التفكير كالنموذج: فهم كيفية معالجة الروبوتات الآلية للغة بشكل مختلف عن البشر أو حتى روبوتات البحث التقليدية

عندما تقوم بتحسين كيفية تفسير الآلات للمحتوى الخاص بك - وليس فقط كيفية رؤية الأشخاص له - فإنك تزيد من احتمالات أن ما يظهر في ملخص الذكاء الاصطناعي يعكس بالفعل ما قصدته. هذا هو جوهر GEO. فهو يمنحك طريقة للتراجع، لتوجيه النظام نحو شيء أقرب إلى الحقيقة.

لا، إنها ليست مضادة للرصاص. لكنه حاجز. وفي عالم يخطئ فيه الذكاء الاصطناعي حتماً، قد يكون هذا الحاجز هو الشيء الوحيد الذي يقف بين جمهورك ونسخة من علامتك التجارية غير حقيقية.

التنظيم وفجوة الشفافية في البحث عن الذكاء الاصطناعي

لقد جلب البحث بالذكاء الاصطناعي نوعًا جديدًا من التعتيم. فأنت تكتب سؤالاً، وتحصل على إجابة واثقة وجيدة الصياغة - ولن يفكر معظم الناس مرتين حول مصدرها. يبدو النظام بشرياً، ولكن المصدر؟ غالبًا ما يكون مفقودًا أو مدفونًا أو مقطوعًا إلى شرائح رقيقة يستحيل تتبعها.

حتى عندما تظهر الاقتباسات، فإنها عادةً ما تكون مدسوسة في القوائم المنسدلة أو مرتبطة بشكل غامض بجزء من الإجابة، وليس كل شيء. تبدو إجابة الذكاء الاصطناعي مصقولة وكاملة، مما يجعل من السهل تجاهل المصدر تمامًا - إذا كان مرئيًا أصلاً.

وهنا تبدأ الثقة في الانهيار. يبدو النموذج واثقًا من نفسه، لكن الأساس الذي يقوم عليه ليس دائمًا متينًا. ونادراً ما يكون لدى المستخدمين الأدوات أو السياق لمعرفة الفرق.

لقد دخلنا حقبة لا يكتفي فيها الذكاء الاصطناعي بنقل الحقيقة فحسب، بل يقوم بتنفيذها. وهذا التحول يجبر الشفافية على التحول من مجرد أمر لطيف إلى ضرورة هيكلية. إذا كان الناس سيعتمدون على المعرفة التي يولدها الذكاء الاصطناعي، فيجب على الأنظمة التي تقف وراءها أن تجعل منطقها مرئياً.

في الوقت الحالي، أحد الأدلة الإرشادية القليلة المتوفرة لدينا هي إرشادات تقييم جودة البحث من Google. بالنسبة لفرق تحسين محركات البحث، فهي أقرب ما يكون إلى إطار عمل عام، خاصةً مع تركيزها على E-E-A-A-T: الخبرة والخبرة والموثوقية والجدارة بالثقة.

تصبح الحاجة إلى الدقة غير قابلة للتفاوض في مواضيع مثل الرعاية الصحية والمالية والاستشارات القانونية وأي شيء مرتبط بالعمليات الحكومية. هذه هي المجالات التي يمكن أن تتسبب فيها هلوسات الذكاء الاصطناعي في ضرر حقيقي - وبسرعة.

تقوم منصات البحث بإجراء فحوصات داخلية حول مدى موثوقية مخرجاتها. ولكن من جانب المستخدم، لا يمكن رؤية أي من ذلك. لا توجد نافذة لمعرفة كيفية توليد الإجابة، أو مصدر البيانات، أو مدى ثقة النظام في الواقع. لذلك يتعامل الناس مع استجابات الذكاء الاصطناعي على أنها حقيقة - بينما في الواقع، غالبًا ما تكون مجرد تخمينات مدروسة ترتدي زي اليقين.

هذا هو بالضبط سبب أهمية GEO

لم يعد الأمر مجرد استجابة لسلوك البحث المتغير، بل أصبح إطار عمل استباقي يضع الشفافية في المقدمة والوسط.

في هذا السياق، تعني الشفافية في هذا السياق بناء محتوى يمكن أن يتحدث عن نفسه. يجب أن تُظهر الصفحات بوضوح كيف تم الحصول على المعلومات، ولماذا هي جديرة بالثقة، وأين يقع الخط الفاصل بين الدليل والرأي. إن ترميز المخططات والإشارات الهيكلية ليست مجرد أشياء تقنية لطيفة - إنها الطريقة التي تساعد بها الآلات على فصل الحقائق الثابتة عن التكهنات.

لم تعد هذه مجرد قوائم مرجعية لأفضل الممارسات بعد الآن - إنها خط الأساس الجديد للبقاء مرئيًا على الإنترنت. إذا لم يتم إنشاء المحتوى الخاص بك بطريقة يمكن للأشخاص والآلات على حد سواء التعرف عليه على الفور على أنه جدير بالثقة، فمن المحتمل أن يتم دفنه. وهذا يعني إضافة اقتباسات واضحة في النص مباشرة، بما في ذلك السير الذاتية الحقيقية للمؤلفين التي تثبت الخبرة، واستخدام البيانات المنظمة لتسمية المحتوى الخاص بك بالضبط وما هو المحتوى الخاص بك ولمن هو.

لا يتعلق الأمر بالنظريات، بل هناك بيانات ثابتة وراء ذلك. ينظر جوجل إلى الأصالة وإشارات المؤلف ومقاييس المشاركة. لذلك عندما تتبع ممارسات المحتوى الأخلاقي والشفاف، فإن الأمر لا يتعلق فقط بالقيام بالشيء الصحيح. بل يتعلق أيضًا بكيفية كسب الرؤية.

المشكلة؟ لا يلتزم البحث بالذكاء الاصطناعي دائمًا بهذه القواعد. في الوقت الحالي، لا يتعين على المنصات أن تخبرك كيف تم إنشاء الملخص، أو المصادر التي اعتمدت عليها، أو لماذا تم اختيار تفسير على آخر. لا يوجد مسار تدقيق مطلوب. وهذا يعني أن شركة ناشئة تنشر محتوى دقيقًا يمكن التحقق منه يمكن أن تتفوق في الترتيب - أو يتم اقتباسه بشكل خاطئ - من خلال نموذج تم تدريبه على مصادر قديمة أو منخفضة الجودة.

وهذه هي المشكلة الأكبر. في هذه البيئة، الشفافية ليست مجرد أمر لطيف - بل هي أمر أساسي. إذا كان الذكاء الاصطناعي يتحكم في ما يراه المستخدمون، وما يتم رفعه، وكيفية تأطير المحتوى، فلا يمكننا أن نصمم للقراء البشر فقط بعد الآن. علينا أن نصمم للآلات أيضاً - وأن نفعل ذلك بطريقة يمكن تتبعها واتساقها وصعوبة تشويهها.

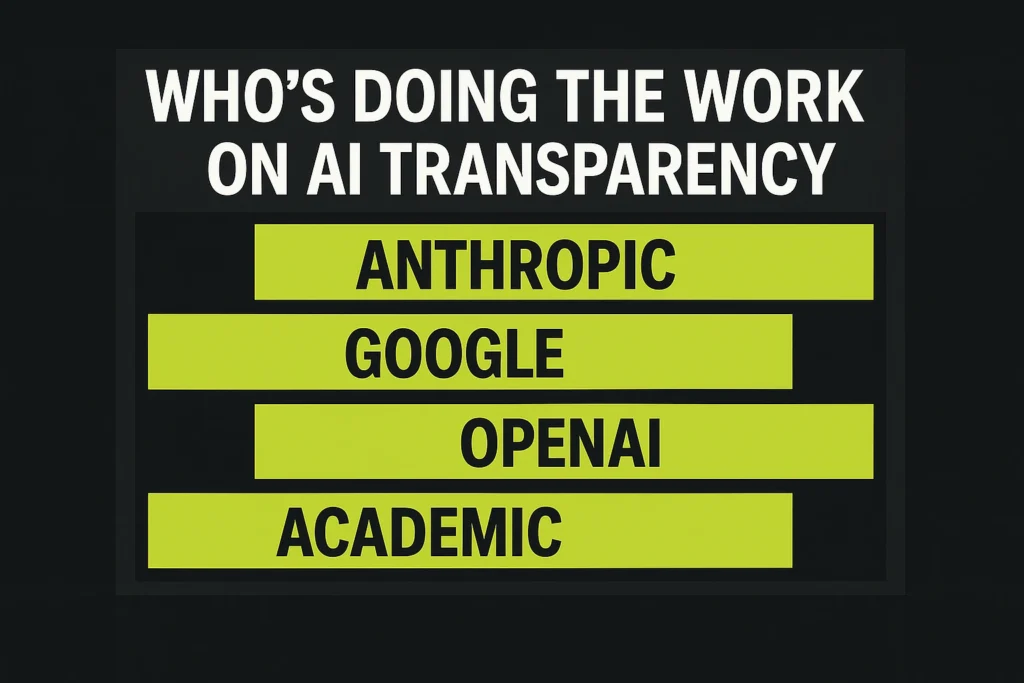

وقد بدأ بعض اللاعبين الرئيسيين في الاستجابة. تستثمر شركات مثل أنثروبيك وOpenAI وجوجل الآن في أبحاث الشفافية ونشر أطر عمل السلامة. بالنسبة لأي شخص يتطلع إلى فهم كيفية عمل هذه الأنظمة - وأين توجد حواجز الحماية - هناك عدد قليل من الموارد الرئيسية المتاحة بالفعل.

من الذي يقوم بالفعل بالعمل على شفافية الذكاء الاصطناعي؟

إذا كنت تحاول فهم كيفية تعامل الجهات الفاعلة الرئيسية مع السلامة والمساءلة في مجال الذكاء الاصطناعي، فإليك تفصيلاً سريعاً للمكان الذي يجب أن تبحث فيه - وما تركز عليه كل مجموعة.

1. الأنثروبولوجيا

- البحث: التعمق في كيفية عمل نماذجها والمخاطر التي تشكلها والتأثير المجتمعي الأوسع نطاقاً

- مركز الشفافية: تحليل العمليات الداخلية والمبادئ الكامنة وراء تطوير الذكاء الاصطناعي المسؤول

- مركز الثقة: يتتبع كيفية تعاملهم مع الأمن والامتثال وحماية البيانات

2. جوجل

- أبحاث الذكاء الاصطناعي: يغطي كل شيء بدءاً من النماذج التأسيسية إلى مشاريع التعلم الآلي التطبيقية في مجالات مختلفة

- الذكاء الاصطناعي المسؤول: التركيز على العدالة والشمول والاستخدام الأخلاقي للذكاء الاصطناعي

- سلامة الذكاء الاصطناعي: يستكشف كيفية الحفاظ على أمان المنتجات وتثبيتها مع توسع الذكاء الاصطناعي عبر نظام Google البيئي

3. OpenAI

- البحث: توثيق العمل الجاري بشأن تحسين أداء النموذج وقدراته

- السلامة: يوضح كيفية قيام OpenAI بتقييم سلوك النظام والتعامل مع المخاطر عبر عمليات النشر

4. أكاديمي

- arXiv.org: منصة الوصول المفتوح لأوراق أبحاث الذكاء الاصطناعي والمطبوعات المسبقة والرؤى التقنية من المجتمع الأكاديمي العالمي

وتساعد هذه الأدوات والموارد في إزاحة الستار عن كيفية عمل أنظمة الذكاء الاصطناعي بالفعل. ولكن معرفة كيفية عملها هو مجرد خط البداية.

استشراف المستقبل: ما الذي سيأتي بعد ذلك

إن أحد أكبر الأسئلة التي تواجهنا الآن هو ما إذا كنا سنشكل كيفية عمل بحث الذكاء الاصطناعي - أو ندعه يشكل كيفية رؤيتنا للعالم. وهذا يتجاوز التصنيفات وحركة المرور. إذا أخطأنا في ذلك، فإننا نخاطر ببناء المستقبل على أساس من المعلومات الخاطئة والتخمين.

لذا فالخيار أمامنا. يمكننا الاستمرار في التعامل مع البحث بالذكاء الاصطناعي كنظام للاستغلال - لعبة نلعبها - أو يمكننا التعامل معه على أنه تحدٍ أخلاقي كما هو في الواقع. إن GEO و Relevance Engineering ليست مجرد كلمات طنانة جديدة. إنهما الأساس لبناء أنظمة معلومات دقيقة وشفافة ومفيدة بالفعل على نطاق واسع.

قد تكون الخوارزميات التي تدير هذه الأنظمة خفية، ولكن تأثيرها على ما نعتقده - وكيف نتصرف - حقيقي للغاية. إن الازدهار في هذا المجال الجديد يعني تجاوز تحسين محركات البحث التقنية. إنه يعني الالتزام بالوضوح والمساءلة والحقيقة.

لأنه في عالم تجلس فيه الآلات بين السؤال والإجابة، لا يكفي أن تكون قابلاً للعثور عليك. يجب أن تكون جديراً بالثقة أيضاً. وهذه لم تعد مكافأة لطيفة، بل هي الأساس.

الأسئلة الشائعة

يركز تحسين محركات البحث التقليدية على تحسين محركات البحث التي تعرض نتائج ثابتة بناءً على الكلمات المفتاحية والروابط وإشارات الصفحة. أما GEO، أو التحسين التوليدي للمحركات، فهو استجابة للبحث القائم على الذكاء الاصطناعي - حيث يتم إنشاء الإجابات ديناميكيًا بواسطة نماذج اللغة. لا يتعلق GEO بالترتيب فقط؛ بل يتعلق بضمان تفسير المحتوى الخاص بك بشكل صحيح، والاستشهاد به بشكل عادل، وعدم تشويهه بواسطة الملخصات الاصطناعية.

لأنه عندما تبدأ أنظمة الذكاء الاصطناعي في إعادة كتابة الإنترنت في الوقت الفعلي، فإن صوت علامتك التجارية ودقتها ومصداقيتها لم تعد تحت سيطرتك بالكامل. تتمحور أخلاقيات GEO حول تحمل هذه المسؤولية - التأكد من أن المحتوى الذي تنشئه واضح وقابل للتحقق منه ويصعب تحريفه. لا يتعلق الأمر بالتلاعب بالنظام. بل يتعلق الأمر بحماية الحقيقة في بيئات غالباً ما تتفوق فيها الثقة على الصواب.

ليس بالضبط. لا تزال جودة المحتوى مهمة، لكن GEO يضيف طبقة أخرى: كيف تفهم الآلات هذا المحتوى. قد تُقرأ الصفحة بشكل جميل بالنسبة للإنسان، ولكنها قد تربك نموذج اللغة إذا كانت تفتقر إلى البنية أو الإشارات أو الوضوح. يعمل GEO على سد هذه الفجوة - ترجمة الجودة إلى شيء يمكن لأنظمة الذكاء الاصطناعي التعامل معه بالفعل.

لا. الهلوسة هي مخاطرة مخبوزة مع الأنظمة التوليدية - سوف يختلقون الأشياء. لكن GEO يمنحك فرصة لتقليل احتمالات سوء اقتباس المحتوى الخاص بك أو تحريفه أو تلفيقه بالكامل. فكّر في الأمر على أنه أقل من كونه إصلاحاً وأكثر من كونه مرشحاً. إذا لم تقم بصياغة ما يتم سحبه، فأنت تحت رحمة ما يتم اختلاقه.