Die KI-gestützte Suche läuft nicht nach einem einzigen Schema ab. Ja, die meisten Plattformen stützen sich auf eine Mischung aus Vektor-Retrieval, Ranking-Modellen und großen Sprachmodellen, aber die Art und Weise, wie sie diese Teile zusammenfügen, kann sehr unterschiedlich aussehen. Diese Unterschiede wirken sich auf alles aus, von der Geschwindigkeit über die Transparenz bis hin zu der Frage, wie nützlich die Antworten sind.

Für jeden, der sich mit generativer Suchmaschinenoptimierung (GEO) beschäftigt, ist das Verständnis dieser Unterschiede keine Option. Was Ihre Inhalte in den KI-Funktionen von Google auftauchen lässt, wird möglicherweise in Perplexity oder Bing überhaupt nicht registriert und umgekehrt. Die Kenntnis der Mechanismen hinter den einzelnen Systemen ist der erste Schritt, um Ihre Inhalte auffindbar zu machen.

Dieser Artikel wirft einen genaueren Blick auf die Architektur der bekanntesten Akteure. Wir werden untersuchen, wie sie ihre Pipelines aufbauen, welche Entscheidungen sie in Bezug auf Indizierung und Synthese treffen und was diese Entscheidungen für die Sichtbarkeit Ihrer Marke bedeuten.

Warum Retrieval-Augmented Generation wichtig ist

Das Rückgrat der heutigen KI-Suchwerkzeuge ist ein Design, das als Retrieval-augmented Generation (RAG) bekannt ist. Es ist im Wesentlichen eine Möglichkeit, zwei der größten Schwächen von Sprachmodellen zu beheben: ihre Angewohnheit, Dinge zu erfinden, und die Tatsache, dass ihre Trainingsdaten veraltet sind. Indem die Generierung an aktuelle oder häufig aktualisierte Quellen gebunden wird, trägt RAG dazu bei, dass die Antworten genau und relevant bleiben.

Der Prozess läuft in der Regel folgendermaßen ab: Das System nimmt die Frage eines Nutzers auf und wandelt sie in einen oder mehrere dichte Vektoren um. Diese Vektoren werden mit einem Index gespeicherter Einbettungen verglichen, die Inhalte in verschiedenen Formaten darstellen: Text, Video, Bilder oder sogar strukturierte Daten. Das System stellt dann eine Reihe von Kandidaten für Übereinstimmungen zusammen. Bevor diese an das Sprachmodell weitergeleitet werden, ordnet ein ressourcenintensiverer Ranker diese Kandidaten häufig nach Relevanz neu an. Die obersten Slices dieses Satzes bilden den Grundkontext für die Antwort des Modells.

Der Vorteil liegt auf der Hand: Anstatt nur auf monatelange Trainingsdaten zurückzugreifen, kann das Modell auf Informationen zurückgreifen, die kurz zuvor abgerufen wurden. Für GEO-Fachleute bedeutet dies, dass die Sichtbarkeit von zwei Dingen abhängt. Erstens müssen Ihre Inhalte durch umfangreiche Metadaten und klare semantische Signale im Einbettungsraum auffindbar sein. Zweitens müssen sie so geschrieben sein, dass das Modell sie leicht verdauen kann: strukturiert, sachlich und sauber. Wenn Sie eine der beiden Anforderungen nicht erfüllen, wird Ihr Inhalt nicht in die endgültige Antwort aufgenommen.

Semantische Indexierung als Grundlage

Herkömmliche Suchmaschinen stützten sich auf invertierte Indizes, die exakte Wörter abgleichen. Die KI-gesteuerte Suche kehrt dieses Modell um, indem sie Informationen als dichte Vektoren in einer Datenbank speichert. Jedes Dokument wird nicht allein durch Schlüsselwörter dargestellt, sondern durch numerische Muster, die seine Bedeutung in einem hochdimensionalen Raum erfassen. Deshalb können eine Abfrage und eine Passage auch dann miteinander in Verbindung stehen, wenn sie kein einziges Wort gemeinsam haben.

Moderne Systeme setzen auch auf eine multimodale Indexierung. Anstatt Text als einzigen Einstiegspunkt zu behandeln, erstellen sie Einbettungen für Bilder, Audio, Tabellen und andere Formate, die alle mit einer einzigen Dokument-ID verknüpft sind. In der Praxis bedeutet dies, dass eine Infografik oder ein Produktfoto auf Ihrer Website als Beweis in einer generativen Antwort auftauchen kann, selbst wenn der umgebende Text nicht konkurrenzfähig ist.

Für GEO ist die Lektion einfach: semantische Klarheit gewinnt. Inhalte sollten Ideen in einfacher Sprache formulieren und nicht in Fachjargon vergraben. Bilder brauchen aussagekräftige Alt-Texte und Bildunterschriften. Audio- und Videomaterial sollte Transkriptionen und Metadaten enthalten, die den Inhalt beschreiben. Je reichhaltiger und klarer Ihre Signale sind, desto größer ist die Chance, dass Sie in die Suchschicht aufgenommen werden.

Lexikalisches und semantisches Retrieval kombinieren

Auch wenn die Vektorsuche das Spiel verändert hat, verlassen sich die meisten KI-Suchsysteme nicht allein auf sie. Sie verwenden einen hybriden Ansatz, der die Stärken sowohl der semantischen als auch der traditionellen schlagwortbasierten Suche kombiniert.

Lexikalische Methoden sind immer dann von Vorteil, wenn Präzision gefragt ist - denken Sie an seltene Begriffe, Produkt-IDs oder exakte Namen. Semantische Methoden hingegen zeichnen sich durch eine breitere Bedeutung aus und zeigen Inhalte auf, die zwar nicht Wort für Wort übereinstimmen, aber der Absicht entsprechen. Indem man beide Ansätze nebeneinander laufen lässt und dann einen Reranker zur Verfeinerung der Ergebnisse einsetzt, können Plattformen das Beste aus beiden Welten erhalten.

In der Praxis sieht dies oft wie eine BM25-Schlüsselwortsuche aus, die parallel zu einer Vektorsuche mit den nächsten Nachbarn läuft. Die Ergebnisse werden zusammengeführt, normalisiert und durch ein kontextbezogenes Modell, das die Relevanz auf Passagenebene gewichtet, neu geordnet. Das Ergebnis ist ein Pool von Ergebnissen, der ein Gleichgewicht zwischen Präzision und Recall herstellt.

Für GEO-Spezialisten ist die Schlussfolgerung klar: Sie dürfen die Grundlagen nicht aufgeben. Die klassische Keyword-Optimierung ist immer noch wichtig für den lexikalischen Abgleich, während die semantische Abdeckung darüber entscheidet, ob Sie im Einbettungsindex auftauchen. Erfolg hat man, wenn man beides gut macht und nicht das eine dem anderen vorzieht.

Wie wir GEO bei Nuoptima angehen

Unter NuoptimaWir haben verstanden, dass sich die Suche verändert hat. Es geht nicht mehr nur darum, blaue Links zu erklimmen - es geht darum, in KI-gesteuerten Umgebungen sichtbar zu sein, in denen Antworten generiert und nicht nur aufgelistet werden. Aus diesem Grund haben wir unseren Ansatz sowohl auf klassische SEO-Grundlagen als auch auf Strategien für die generative Suche zugeschnitten.

So funktioniert es:

- SEO + GEO kombiniert: Wir kümmern uns um alles, von technischen Audits und Website-Reparaturen bis hin zu Content-Strategien, die in AI Overviews, Bing Copilot und Perplexity auftauchen.

- Messbare Ergebnisse: Unsere Kunden haben zusammen mehr als $500 Mio. eingeworben, mit einer durchschnittlichen 3,2-fachen Rendite auf die Werbeausgaben und einem konstanten Wachstum der Besucherzahlen in wettbewerbsfähigen Sektoren.

- Umfangreiche, qualitativ hochwertige Inhalte: Wir veröffentlichen mehr als 800.000 Wörter pro Monat, wobei wir KI-gesteuerte Erkenntnisse mit menschlichem Fachwissen kombinieren, damit die Inhalte sowohl maschinenlesbar als auch für echte Menschen ansprechend sind.

- Globale Reichweite: Unsere internationale SEO-Arbeit stellt sicher, dass Marken mit der richtigen Struktur und den richtigen Metadaten über Sprachen und Regionen hinweg skalieren können.

- Bewährtes Vertrauen: Mehr als 70 Branchenführer zählen auf uns, wenn es darum geht, nachhaltiges Wachstum zu erzielen, nicht nur kurzfristige Gewinne.

Unser Fokus ist einfach: Wir entwickeln Relevanz. Indem wir Inhalte klar, strukturiert und glaubwürdig gestalten, helfen wir Marken, sich ihren Platz in den von KI-Plattformen generierten Antworten zu sichern - und dort zu bleiben, wenn sich die Suchlandschaft weiterentwickelt.

Die KI-Suche von Google: Übersichten und KI-Modus

Googles Einstieg in die generative Suche baut direkt auf seiner langjährigen Infrastruktur auf und verbindet große Sprachmodelle mit den Suchsystemen, die es seit Jahrzehnten verfeinert hat. Anstatt KI-Antworten als Zusatzfunktion zu behandeln, hat Google sie in den Kern der Suche integriert.

Wenn Sie eine Suchanfrage eingeben, führt Google nicht nur eine einzige Suche durch. Es zerlegt die Abfrage in mehrere Blickwinkel - Variationen, die verschiedene potenzielle Absichten erfassen. Diese Nebenabfragen werden an mehrere Quellen gleichzeitig gesendet: den Haupt-Webindex, den Knowledge Graph, YouTube-Transkripte, Shopping-Feeds und andere spezialisierte Datenbanken.

Die Ergebnisse aus jeder Quelle werden gesammelt, gefiltert und dedupliziert, bevor sie an ein Gemini-basiertes Modell weitergegeben werden. In den KI-Übersichten erstellt das Modell eine prägnante Zusammenfassung und platziert sie oben auf der Ergebnisseite mit eingeflochtenen Zitaten. Im KI-Modus wechselt das Erlebnis in einen Gesprächsfluss, bei dem der Kontext über mehrere Runden hinweg erhalten bleibt und das System während der Diskussion zusätzliche Informationen abrufen kann.

Für GEO ist das von großer Bedeutung: Google belohnt Inhalte, die mehrere Aspekte einer Suchanfrage abdecken können. Wenn Ihre Seite nur einen Teilaspekt abdeckt, laufen Sie Gefahr, nicht berücksichtigt zu werden. Seiten, die verwandte Ziele ansprechen, klare, in sich geschlossene Passagen präsentieren und Autorität demonstrieren, haben eine viel bessere Chance, in der Synthese aufzutauchen.

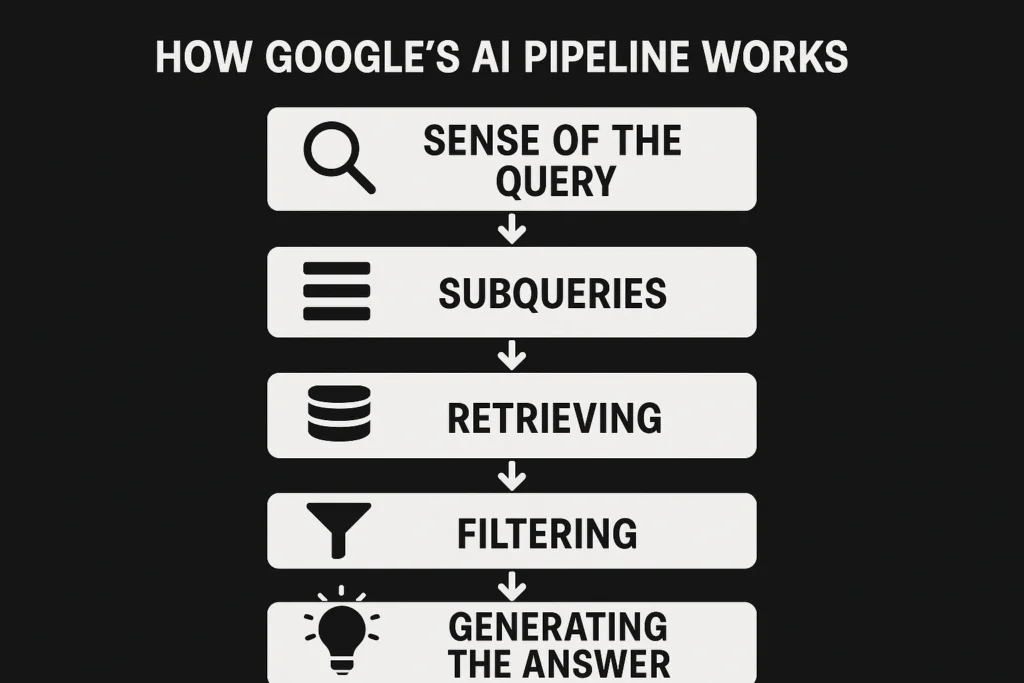

Wie die KI-Pipeline von Google hinter den Kulissen funktioniert

Auch wenn sich die Oberfläche neu anfühlt, werden die KI-Übersichten und der KI-Modus von Google von Prozessen angetrieben, die tief in den Such-Stack integriert sind. Basierend auf dem, was aus Patenten, öffentlichen Erklärungen und beobachteten Verhaltensweisen ersichtlich ist, scheint das System fünf Schlüsselphasen zu folgen:

1. Sinnhaftigkeit der Abfrage

Der erste Schritt ist das Parsen der Anfrage auf verschiedene Arten. Google erzeugt verschiedene Darstellungen: eine lexikalische Version für den exakten Wortabgleich, dichte Einbettungen für die semantische Suche, Entitäten, die dem Knowledge Graph zugeordnet sind, und ein Aufgabensignal, das definiert, welche Art von Antwort benötigt wird - ein Vergleich, eine Anleitung oder eine Zusammenfassung. Außerdem werden grundlegende Aufgaben wie Spracherkennung und Rechtschreibkorrekturen erledigt. Nicht jede Anfrage qualifiziert sich für eine KI-Antwort; sensible oder wichtige Suchanfragen werden oft herausgefiltert.

2. Erweitern mit Unterabfragen

Wenn die Anfrage zulässig ist, verzweigt Google sie in mehrere Unterabfragen, um versteckte Absichten zu erfassen.

Nehmen wir als Beispiel die Frage: "Wie lege ich einen Gemüsegarten an". Sie könnte sich verzweigen in:

- "Tipps für Anfänger im Gemüseanbau"

- "Gemüseanbaukalender nach Jahreszeiten"

- "Beste Erde für Gemüsegärten"

- "Werkzeuge für die Gartenarbeit zu Hause"

Jede Unterabfrage wird an die relevanteste Quelle weitergeleitet, sei es der Webindex, YouTube-Transkripte, Shopping-Feeds oder Maps.

3. Abruf aus mehreren Quellen

Jede Unterabfrage wird durch die entsprechende Suchmaschine geleitet. Für Web-Ergebnisse könnte dies BM25-Schlüsselwortabgleich neben vektorbasierter semantischer Suche bedeuten. Andere Quellen stützen sich auf andere Methoden - Graph-Traversal für Knowledge-Graph-Fakten, multimodale Einbettungen für Videos oder Bilder. Dokumente werden oft in kleinere Teile mit eigenen Einbettungen zerlegt, was die Auffindbarkeit auf einer detaillierteren Ebene verbessert.

4. Zusammenführung und Filterung

Die zurückgegebenen Ergebnisse werden gebündelt, Duplikate entfernt und Filter angewendet. Google prüft Vertrauenssignale (E-E-A-T), Aktualität, Sicherheitsprüfungen und ob Passagen sauber genug sind, um direkt zitiert zu werden. Wenn das System keine extrahierbaren Snippets finden kann, werden diese Seiten mit geringerer Wahrscheinlichkeit zitiert, selbst wenn sie relevant sind.

5. Generierung der Antwort

Schließlich nimmt ein auf Gemini basierendes Modell die wichtigsten Passagen und verwebt sie zu einer synthetischen Antwort. Zitate können inline, in seitlichen Feldern oder als erweiterbare Listen von Quellen erscheinen. AI Overviews zielen auf prägnante Zusammenfassungen in einem Durchgang ab, während der AI Mode längere Unterhaltungen mit mehreren Durchgängen ermöglicht, bei denen je nach Bedarf weitere Belege abgerufen werden.

Was dies für GEO bedeutet: Der Erfolg hängt davon ab, dass man mehrere zusammenhängende Absichten abdeckt, Passagen schreibt, die für sich allein stehen und klare, extrahierbare Antworten geben, und Autorität signalisiert. Seiten, die diese Kriterien erfüllen, haben eine viel größere Chance, in den KI-Ergebnissen von Google aufzutauchen und zitiert zu werden.

ChatGPT: Ein Modell ohne eigenen Index

Anders als Google oder Bing unterhält ChatGPT keinen eigenen ständigen Webindex. Das Kernmodell wird auf einem riesigen, eingefrorenen Datensatz trainiert, aber wenn das Browsing aktiviert ist, hängt es vom Live-Retrieval ab. Wenn ein Benutzer eine Frage stellt, formuliert ChatGPT diese in eine suchähnliche Anfrage um und schickt sie durch externe Suchmaschinen, meistens Bing und gelegentlich Google. Von dort erhält es eine Handvoll Links zurück, holt den Inhalt in Echtzeit ab und verarbeitet dieses Material direkt, um seine Antwort zu erstellen.

Diese Einstellung hat wichtige Konsequenzen. Ob Ihre Inhalte erscheinen, hat nichts mit der historischen Autorität oder dem langfristigen Ranking zu tun. Es hängt ausschließlich davon ab, ob Ihre Seiten zum Zeitpunkt der Abfrage abgerufen und analysiert werden können. Wenn Ihre Website in robots.txt blockiert ist, durch langsames Laden behindert wird, hinter clientseitigem Rendering versteckt ist oder in einer Weise geschrieben ist, die für das Modell zu undurchsichtig ist, um sie zu analysieren, wird sie in der Synthesestufe überhaupt nicht auftauchen.

Um in diesem Umfeld sichtbar zu sein, orientiert sich das Regelwerk eher an den klassischen SEO-Grundlagen. Die Seiten müssen schlank, technisch crawlbar und semantisch transparent sein. In der Praxis bedeutet das: sauberes HTML, schnelle Leistung, keine Blocker für Crawler und Inhalte in einfacher, extrahierbarer Sprache. Wenn das Modell nach Echtzeit-Kontext sucht, sind das die Seiten, die es tatsächlich nutzen kann.

Bing Copilot: Suche trifft auf generative KI

Der Copilot von Bing zeigt, was passiert, wenn eine ausgereifte Suchmaschine mit einem Konversationsmodell verschmolzen wird. Anstatt jahrzehntelange Rankingsysteme zu verwerfen, hat Microsoft den Bing-Index umgestaltet und dann eine GPT-ähnliche Ebene hinzugefügt, um die Ergebnisse zusammenzufassen. Der Effekt ist, dass alle bekannten SEO-Grundlagen immer noch entscheiden, welche Seiten es in den Pool schaffen, während Klarheit und Struktur bestimmen, welche Seiten tatsächlich in den Antworten zitiert werden.

Die Pipeline sieht in der Regel folgendermaßen aus.

Schritt 1: Interpretation der Fragen

Wenn eine Anfrage eingeht, liest Copilot sie nicht nur für bare Münze. Er erstellt mehrere parallele Interpretationen: eine für den traditionellen Schlüsselwortabgleich, eine für die semantische Ähnlichkeit über Einbettungen und eine weitere, die Entitäten dem Knowledge Graph von Bing zuordnet. Es markiert auch die Absicht der Anfrage: ob es sich um eine Suche nach Fakten, eine Anleitung oder einen Produktvergleich handelt, und nutzt dieses Signal, um zu entscheiden, welche vertikalen Quellen herangezogen werden sollen. Im Gegensatz zu Googles Gewohnheit, Suchanfragen breit zu streuen, hält Bing die Dinge enger und filtert früh.

Schritt 2: Mischen von Schlüsselwörtern und semantischen Übereinstimmungen

Copilot führt sowohl die exakte Suche als auch die semantische Suche im Tandem durch. Die Stichwortsuche eignet sich am besten für eindeutige Bezeichner wie SKUs oder Markennamen, während die semantische Suche konzeptionell verwandte Passagen einbezieht. Die Ergebnisse werden gemischt, normalisiert und nach Aktualität und Qualität der Website gefiltert. Da der Index von Bing bereits kuratiert ist, ist das, was durchkommt, in der Regel solide, crawlbar und kanonisch. Aus diesem Grund ist einfache Hygiene - klare kanonische Signale, schnelle Ladezeiten, sauberes HTML - hier immer noch so wichtig.

Schritt 3: Auswahl der richtigen Passagen

In diesem Stadium wendet Bing einen fortschrittlicheren Reranker an, der Abfrage und Passage zusammen betrachtet. Es behandelt die Seiten nicht mehr als monolithisch, sondern bewertet die einzelnen Abschnitte. Das Modell bevorzugt Passagen, die kurz und knapp sind und leicht wiederverwendet werden können - eine Definition, eine kurze Erklärung oder ein strukturierter Block wie eine Tabelle. Auch hier kommt die Deduplizierung zum Tragen, die nahezu identische Inhalte entfernt und für Vielfalt sorgt. Vertrauen und Autorität spielen bei Tie-Breaks eine Rolle, so dass eine gut strukturierte Passage von einer angesehenen Domäne die gleiche Idee von einer schwächeren Website übertrifft.

Schritt 4: Passagen in eine Antwort umwandeln

Die besten Passagen werden an ein Modell der GPT-Klasse weitergegeben, das eine Zusammenfassung auf der Grundlage dieser Belege erstellt. Die Generierung durch Copilot ist eng begrenzt: Es ist darauf ausgelegt, zu paraphrasieren und zu synthetisieren, nicht zu erfinden. Bei längeren Chats kann es zusätzliche Abfragen anfordern, wenn neue Aspekte auftauchen, aber das Gesamtmuster bleibt auf dem basieren, was tatsächlich abgerufen wurde. Für Website-Besitzer bedeutet dies, dass es am besten ist, Behauptungen klar und eindeutig zu formulieren, so dass das Modell sie aufnehmen kann, ohne mit mehreren Fragmenten zu jonglieren.

Schritt 5: Anzeigen von Ergebnissen und Aktivieren von Aktionen

Sobald die Synthese abgeschlossen ist, zeigt Copilot die Antwort mit angehängten Zitaten an. Diese erscheinen oft als hochgestellte Inline-Zitate oder kurze Listen unter der Antwort. Im Gegensatz zu den umfassenderen Übersichten von Google neigt Copilot dazu, die Liste der Zitate klein und präzise zu halten, da die Fundierung auf der Ebene der Passage erfolgt. Was Copilot auszeichnet, ist die tiefe Integration in Microsoft 365: Antworten können direkt in Word, Excel oder Teams übernommen werden. Das macht strukturierte Formate - Tabellen, Listen, Checklisten - besonders leistungsfähig, da sie sich nahtlos in die Arbeitsabläufe der Nutzer einfügen.

Warum es Seiten manchmal nicht schaffen

Eine Seite kann in den Standard-Ergebnissen von Bing rangieren, aber in den Copilot-Zitaten nicht auftauchen. Die üblichen Gründe sind nicht thematisch, sondern strukturell: langsames Rendering auf der Client-Seite, das den Text verzögert, unübersichtliche Seitenlayouts, die die Extraktion verwirren, oder lange Textabschnitte, die die Hauptaussage verbergen. Schwache Autoren- oder Entitätssignale können auch dann schaden, wenn konkurrierende Passagen ansonsten gleichwertig sind.

Das GEO-Playbook für Bing Copilot besteht darin, traditionelles SEO plus Technik auf Passagenebene zu denken:

- Wetteifern Sie beim lexikalischen und semantischen Abruf.

- Stellen Sie Behauptungen in kurzen, leicht verständlichen Passagen dar.

- Verstärkung der Entitäts- und Autorensignale.

- Halten Sie Seiten mit versionierten oder veralteten Inhalten auf dem neuesten Stand.

- Bieten Sie Inhalte in Formaten an, die sich gut in die Arbeitsabläufe der Nutzer einfügen, z. B. Listen oder Tabellen.

Perplexity AI: Ein transparenter Ansatz für die generative Suche

Perplexity AI zeichnet sich dadurch aus, dass es seine Arbeit offen zeigt. Während Google und Bing Synthese und Quellenangaben oft auf eine Art und Weise vermischen, die verbirgt, was hinter den Kulissen passiert, macht Perplexity seine Zitate klar und sichtbar und listet sie oft sogar vor der generierten Antwort auf. Für die Nutzer bedeutet dies ein besseres Gefühl dafür, woher die Informationen stammen. Für GEO-Fachleute ist es eine ungewöhnliche Chance, Abruf- und Zitationsmuster fast in Echtzeit zu beobachten.

Perplexity verfügt über keinen eigenen permanenten Index. Jedes Mal, wenn eine Anfrage eingegeben wird, wird eine neue Suche durchgeführt, die in der Regel auf Bing und Google basiert. Die Kandidaten werden dann nicht nur nach ihrer Relevanz bewertet, sondern auch nach Eigenschaften wie Klarheit, Autorität und ob der Inhalt leicht in eine Antwort umgewandelt werden kann.

Was die Ratlosigkeit belohnt

- Direkte Antworten: Prägnante Passagen, die die Anfrage wiederholen und eine klare Antwort im Voraus geben.

- Klarheit der Entität: Direkte Nennung von Namen, Unternehmen, Produkten und Orten, unterstützt durch Schema- oder Kontextlinks.

- Glaubwürdigkeit des Autors: Lebensläufe, Zeugnisse und Vertrauenssignale der Organisation haben Gewicht.

- Visuelle Unterstützung: Diagramme und Bilder zur Veranschaulichung von Konzepten führen häufig zu höheren Zitierraten.

- Semantische Breite: Seiten, die mehrere Aspekte einer Anfrage abdecken, ohne vom Thema abzuschweifen, werden zuverlässiger angezeigt.

Wenn jemand beispielsweise fragt: "Was unterscheidet GPT-4 von GPT-5?", wird Perplexity eher eine Seite verwenden, auf der genau dieser Satz in der Überschrift steht, unmittelbar gefolgt von einer kurzen Erklärung. Langatmige Inhalte oder Antworten, die tief auf der Seite vergraben sind, haben in der Regel das Nachsehen.

Warum es für GEO wichtig ist

Was Perplexity unter dem Gesichtspunkt der Optimierung so wertvoll macht, ist seine Transparenz. Sie können genau sehen, welche Quellen zitiert werden, sie mit Ihren eigenen vergleichen und schnell anpassen. Wenn Ihre Seite ausgeschlossen wird, ist der Grund dafür in der Regel leicht zu erkennen: Vielleicht ist Ihre Antwort nicht extrahierbar genug, oder Ihre Entitäten sind nicht klar definiert, oder ein Konkurrent hat denselben Inhalt sauberer strukturiert.

Hier gilt es, Inhalte als modulare Antworteinheiten zu gestalten: Beginnen Sie mit einer knappen, zitierfähigen Antwort, und erweitern Sie sie dann mit unterstützenden Details, Beispielen und Bildmaterial. Fügen Sie Kontext für Unternehmen hinzu und verstärken Sie Vertrauenssignale durch Biografien und organisatorische Details.

Perplexity kann vielleicht nicht mit Google mithalten, was den reinen Traffic angeht, aber es ist wohl das beste Labor, um zu testen, was bei der generativen Suche funktioniert. Die Muster, die Sie hier bestätigen, können dann auf Plattformen übertragen werden, die weit weniger transparent sind.

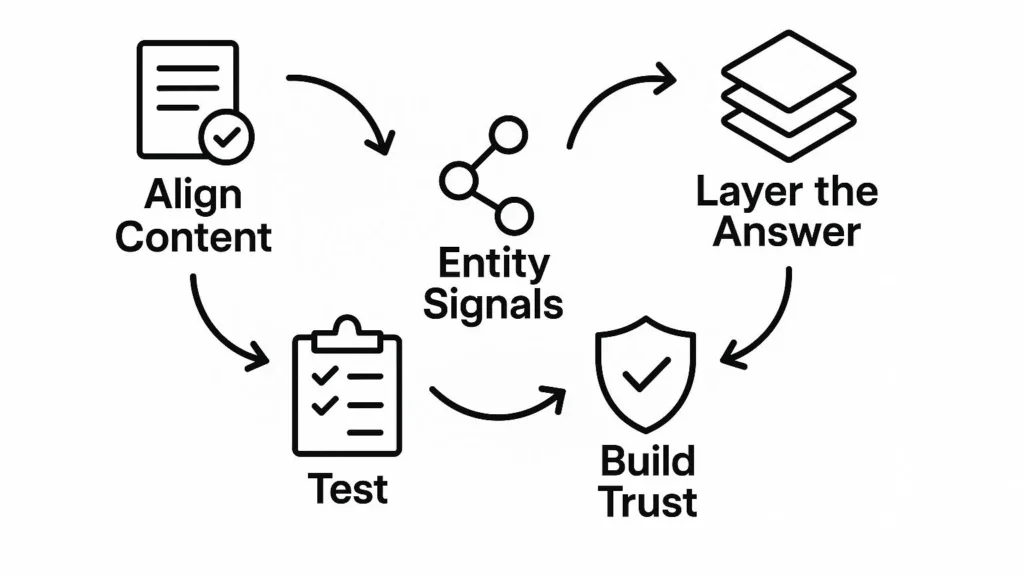

GEO Strategie für Verwirrung

Perplexity ist kein passives Verzeichnis von Ergebnissen - es ist ein aktiver Retriever, der aggressiv nach Klarheit, Präzision und Vertrauen filtert. Um hier zitiert zu werden, müssen die Inhalte so aufgebaut sein, dass das System sie direkt in seine synthetischen Antworten übernehmen kann.

Inhalt auf den Abfragerahmen abstimmen

- Geben Sie die Frage in einer Überschrift oder Zwischenüberschrift wieder.

- Geben Sie sofort eine kurze, erklärende Antwort.

- Sorgen Sie dafür, dass der einleitende Satz für sich allein stehen kann, ohne dass ein zusätzlicher Kontext erforderlich ist.

Beispiel: Eine Abfrage wie "Was ist Quantentunneling?" sollte mit einer Abschnittsüberschrift, in der der Begriff wiederholt wird, und einer Ein-Satz-Definition beantwortet werden, die in der Perplexity-Ausgabe allein stehen kann.

Entitätssignale stärken

- Klare Benennung und Verknüpfung der wichtigsten Einheiten (Unternehmen, Personen, Produkte, Orte).

- Verwenden Sie Schema-Auszeichnungen, wo immer möglich.

- Umgeben Sie Entitäten mit kontextuellen Details, damit sie leicht zu unterscheiden sind.

Wenn mehrere Seiten ähnliche Antworten liefern, gewinnt in der Regel die Seite, die ein stärkeres semantisches Netz von Entitäten schafft.

Schichtung der Antwort für unterschiedliche Tiefen

- Beginnen Sie mit einer prägnanten, zitierfähigen Erklärung.

- Fügen Sie eine Erweiterung auf mittlerer Ebene hinzu, die für Nuancen sorgt.

- Unterstützen Sie das Thema mit Diagrammen, Beispielen oder Faktenkästen, um es zu vertiefen.

Auf diese Weise hat Perplexity mehrere Optionen zur Auswahl, je nachdem, ob das System einen kurzen Ausschnitt oder eine ausführlichere Passage wünscht.

Bauen Sie Vertrauen in die Seite ein

- Fügen Sie Lebensläufe der Autoren, Referenzen und organisatorische Informationen hinzu.

- Führen Sie glaubwürdige Quellen direkt an.

- Streben Sie an, mit angesehenen Kollegen in der gleichen Antwortgruppe zu erscheinen.

Auch wenn Perplexity keine explizite "E-E-A-T-Note" ausweist, verhält es sich durchweg so, als ob Autoritätssignale wichtig wären.

Kontinuierlich testen und anpassen

Da Perplexity seine Zitate sichtbar macht, bietet es eine Feedbackschleife, die bei der KI-Suche selten ist. Sie können nachverfolgen, welche Seiten auftauchen, sie mit Ihren eigenen vergleichen und die Struktur der Inhalte verfeinern, bis sie besser abschneiden. Die gleichen Erkenntnisse können dann auf weniger transparente Systeme wie Google AI Mode oder Bing Copilot angewendet werden.

Vergleich der GEO-Taktiken auf verschiedenen AI-Plattformen

Jedes generative Suchsystem läuft nach dem gleichen Schema ab: Ergebnisse sammeln, verfeinern und zur Generierung einer Antwort verwenden. Aber die wichtigsten Hebel sind nicht einheitlich. Was bei einer Suchmaschine für eine Erwähnung sorgt, ist bei einer anderen möglicherweise nicht von Bedeutung.

Betrachten Sie es einmal so:

- Wenn Ihr Inhalt nicht abgerufen werden kann, kommt er nicht ins Gespräch.

- Wenn es nicht sauber angehoben werden kann, wird es nicht zu Erdungsmaterial.

- Fehlt es an Autorität, kann es übergangen werden, auch wenn es relevant ist.

Hier ist die Aufstellung der wichtigsten Akteure.

Die KI-Funktionen von Google

Die Übersichten und der KI-Modus von Google erweitern die Suchanfragen der Nutzer in mehrere Richtungen, indem sie auf Web-Ergebnisse, Knowledge Graph-Daten und vertikale Indizes zurückgreifen. Seiten, die mehrere Facetten einer Frage in klaren und extrahierbaren Snippets beantworten, werden am häufigsten angezeigt. Starke Entitätsabdeckung und Glaubwürdigkeitsmarker haben zusätzliches Gewicht.

Microsoft Bing Copilot

Copilot verbindet das klassische Ranking-System von Bing mit generativer Synthese. Um berücksichtigt zu werden, müssen Ihre Inhalte sowohl bei der Stichwortsuche als auch bei der semantischen Suche gut abschneiden. Sobald Sie im Pool sind, haben kurze, knappe Passagen - Listen, Definitionen oder kurze Erklärungen - die besten Chancen, zitiert zu werden. Signale wie Aktualität, Schemaauszeichnung und Vertrauenswürdigkeit des Autors geben den Ausschlag.

ChatGPT mit Browsing

ChatGPT generiert seine eigenen Suchanfragen und zieht einen kleinen Satz von Seiten zur Laufzeit. Das bedeutet, dass der Erfolg hier davon abhängt, dass die Seite sofort verfügbar und einfach zu bearbeiten ist, und nicht von einer langfristigen Ranking-Autorität. Sauberes HTML, schnelle Ladezeiten und Titel oder Überschriften, die die Art und Weise widerspiegeln, wie Nutzer ihre Fragen formulieren, verbessern die Chancen, aufgenommen zu werden.

Perplexität AI

Perplexity führt für jede Anfrage eine neue Suche durch und zeigt die Quellen offen an. Da kein ständiger Index vorhanden ist, müssen Ihre Inhalte schnell und crawlbar sein und von Maschinen leicht analysiert werden können. Direkte, in sich geschlossene Antworten und ein starker Entity-Kontext sind am besten geeignet. Die Transparenz macht es zu einer nützlichen Testumgebung für GEO-Strategien, auch wenn das Verkehrsaufkommen geringer ist als bei Google.

GEO-Kurzreferenz nach Plattform

| Plattform | Retrieval-Ansatz | Index-Einrichtung | Was am wichtigsten ist | Wie die Zitate erscheinen | Warum Seiten ausgeschlossen werden |

| Google AI Übersichten & AI-Modus | Zerlegt Abfragen in mehrere Varianten (Schlüsselwörter, Einbettungen, Entitäten) und sucht in verschiedenen Quellen | Vollständiger Google-Webindex plus Knowledge Graph und vertikale Datenbanken | Mehrere Aspekte der Anfrage abdecken, saubere Passagen schreiben, die aufgehoben werden können, Sachkenntnis und Vertrauen demonstrieren | Inline-Links, Seitentafeln oder "Weitere Quellen"-Karten | Seiten stimmen nicht mit Unterabfragen überein, Passagen sind schwer zu extrahieren, oder Vertrauens-/Autoritätssignale sind schwach |

| Bing Copilot | Zweigleisig: Schlagwortsuche (BM25) und semantische Vektorsuche, gefolgt von einem Reranking der Passagen | Bing's vollständiger Web-Index | Starke Präsenz von Schlüsselwörtern und semantischen Signalen, extrahierbare Abschnitte (Listen, kurze Definitionen), Aktualität und Schema-Markup | Inline-Superskripte, die mit Quellkarten verbunden sind | Verzögertes Rendering verdeckt Text, tief in langen Seiten vergrabene Inhalte, fehlendes Entity/Author Markup |

| Perplexität AI | Echtzeit-Aufrufe an externe Suchmaschinen (hauptsächlich Bing/Google) und selektives Abrufen von URLs | Kein ständiger Index - ist auf externe APIs angewiesen | Crawlbare und schnell ladende Seiten, prägnante Antworten, die die Anfrage widerspiegeln, gut definierte Entitäten | Quellenangaben im Vorfeld, dann inline in der Antwort zitiert | Robots.txt-Blockierung, starker JavaScript-Verzögerungstext, langsame Serverreaktion |

| ChatGPT mit Browsing | LLM formuliert die Anfrage neu, sendet sie an Bing (manchmal auch an Google), holt einige URLs und analysiert sie direkt | Kein dauerhafter Index | Klare, semantisch direkte Titel und Überschriften, sofort zugängliche Seiten, saubere HTML-Struktur | Zitate inline oder am Ende, oft teilweise | URL nicht angefordert, Inhalt blockiert oder zu langsam, oder Text nicht leicht zu parsen |

Abschließende Aufschlüsselung der Plattform

Wenn man die großen KI-Suchplattformen nebeneinander vergleicht, wird klar, dass sie nicht nach denselben Regeln spielen. Google weitet das Netz mit Abfrageerweiterungen aus, Bing baut auf seinen etablierten Rankingsystemen auf, Perplexity zeigt seine Quellen offen an und ChatGPT verlässt sich auf das, was es im Moment abrufen kann. Jedes hat seine eigene Balance zwischen Abruf, Filterung und Synthese, und das bedeutet, dass die Optimierungshebel für jedes unterschiedlich sind.

Dennoch ergibt sich eine gemeinsame Reihenfolge. Der Inhalt muss zunächst auffindbar sein, sonst kommt er nicht in Frage. Dann muss er so strukturiert sein, dass er direkt zitiert werden kann, so dass das System ihn mühelos in eine Antwort einfügen kann. Schließlich muss er genügend Autorität und Vertrauenssignale enthalten, um die Filterung zu überstehen. Diese Kontrollpunkte gibt es überall, auch wenn sich die Gewichtung von Maschine zu Maschine ändert.

Ein weiterer wichtiger Punkt ist, dass keine dieser Plattformen mit einer einzigen wörtlichen Abfrage arbeitet. Sie alle formulieren um, was der Nutzer eingegeben hat, um verwandte Absichten zu ermitteln. Der Erfolg beruht weniger auf der Jagd nach einzelnen Schlüsselwörtern als vielmehr auf der Erstellung von Inhalten, die ein ganzes Feld verwandter Fragen bedienen können.

Häufig gestellte Fragen

Herkömmliche Suchmaschinenoptimierung konzentriert sich stark auf die Suche nach Schlüsselwörtern und das Seitenranking. KI-Suchmaschinen gehen weiter: Sie formulieren Anfragen neu, verwenden Einbettungen, um semantisch verwandte Inhalte zu finden, und stützen sich auf Sprachmodelle, um Antworten zu generieren. Das bedeutet, dass der Erfolg nicht nur von Schlüsselwörtern abhängt, sondern auch von Struktur, Klarheit und Autorität.

RAG ist ein System, bei dem ein KI-Modell neue Informationen aus einem Index abruft, bevor es eine Antwort erzeugt. Anstatt sich nur auf das zu verlassen, was es beim Training gelernt hat, stützt es seine Ausgabe auf aktuelle, externe Daten. Dies reduziert Halluzinationen und macht die Antworten zuverlässiger.

Google führt nicht nur eine einzige Abfrage durch. Es zerlegt die ursprüngliche Frage in mehrere Unterabfragen, um verschiedene mögliche Absichten abzudecken. Wenn Ihr Inhalt mehrere dieser Aspekte abdeckt und so geschrieben ist, dass er leicht zitiert werden kann, haben Sie eine höhere Chance, aufgenommen zu werden.

Oft ist es ein strukturelles Problem. Seiten, die langsam laden, deren Kerninhalt stark von JavaScript abhängt, die wichtige Fakten in langen Absätzen verbergen oder denen es an eindeutigen Signalen des Autors oder der Organisation mangelt, sind für KI-Systeme schwerer zu erfassen. Selbst wenn das Thema relevant ist, werden sie möglicherweise übersprungen.

Autorität ist immer noch wichtig - nur auf etwas andere Weise. Vertrauenssignale wie Autorennachweise, konsistente thematische Abdeckung, starke Backlinks und Schema-Markup können entscheidend sein, wenn das System mehrere Passagen zur Auswahl hat.

Perplexity zeigt seine Zitate im Voraus und macht es einfacher zu testen, was funktioniert. Kurze, direkte Antworten unter klaren Überschriften, starke Verlinkungen und schnell ladende Seiten schneiden in der Regel am besten ab. Es belohnt Klarheit und Präzision gegenüber langen, erzähllastigen Seiten.