Früher ging es bei der Suche darum, die richtigen Wörter in der richtigen Reihenfolge einzugeben. Das ist vorbei. In den letzten zwei Jahrzehnten hat sich die Informationssuche vom Abgleichen von Zeichenketten zum Verstehen von Absichten entwickelt. Was als einfache Stichwortsuche begann, ist heute ein vielschichtiger, KI-gestützter Prozess, der Einbettungen, Transformatoren und generative Schlussfolgerungen umfasst.

In diesem Artikel erfahren Sie, wie es dazu gekommen ist und warum die Systeme hinter den heutigen Suchmaschinen viel mehr können als nur Dokumente zu finden.

Die Anfänge: Indizes, Token und TF-IDF

Bevor Suchmaschinen etwas "verstehen" konnten, mussten sie es einfach halten. Frühe Systeme, wie Cornells SMART in den 1960er Jahren, verwendeten eine Architektur, die als invertierter Index bezeichnet wurde - im Wesentlichen eine ausgefallene Nachschlagetabelle, die angab, wo jedes Wort vorkam.

Der Prozess verlief in etwa so:

- Zerlegen Sie die Dokumente in Wörter (Tokenisierung).

- Reduzieren Sie diese Wörter auf ihre Wurzeln (Stemming).

- Speichern Sie eine Liste der Dokumente, die welche Wörter enthalten.

Wenn Sie also nach "running" suchen, könnte das System nach "run" suchen und Ihnen alle Dokumente anzeigen, die diesen Begriff enthalten. Die Suchmaschine hat nicht versucht zu verstehen, was Sie mit "laufen" meinen. Sie hat nur die Zeichen verglichen.

TF-IDF: Ein erster Versuch zur Relevanz

Um die Ergebnisse relevanter zu machen, wandten die Ingenieure TF-IDF (Term Frequency-Inverse Document Frequency) an. Damit wurden Wörter, die in einem Dokument häufig vorkamen, in anderen aber nicht, mit einer höheren Punktzahl bewertet. Das half, einzigartige und relevante Inhalte hervorzuheben.

Aber der Haken an der Sache ist, dass es sich dabei immer noch um einen String-Matching-Prozess handelte. Das System wusste nicht, dass "Auto" und "Automobil" das Gleiche bedeuten. Wenn man nicht das richtige Wort verwendete, konnte man das richtige Ergebnis verpassen.

Und das führte zu einer jahrzehntelangen Besessenheit mit Schlüsselwörtern.

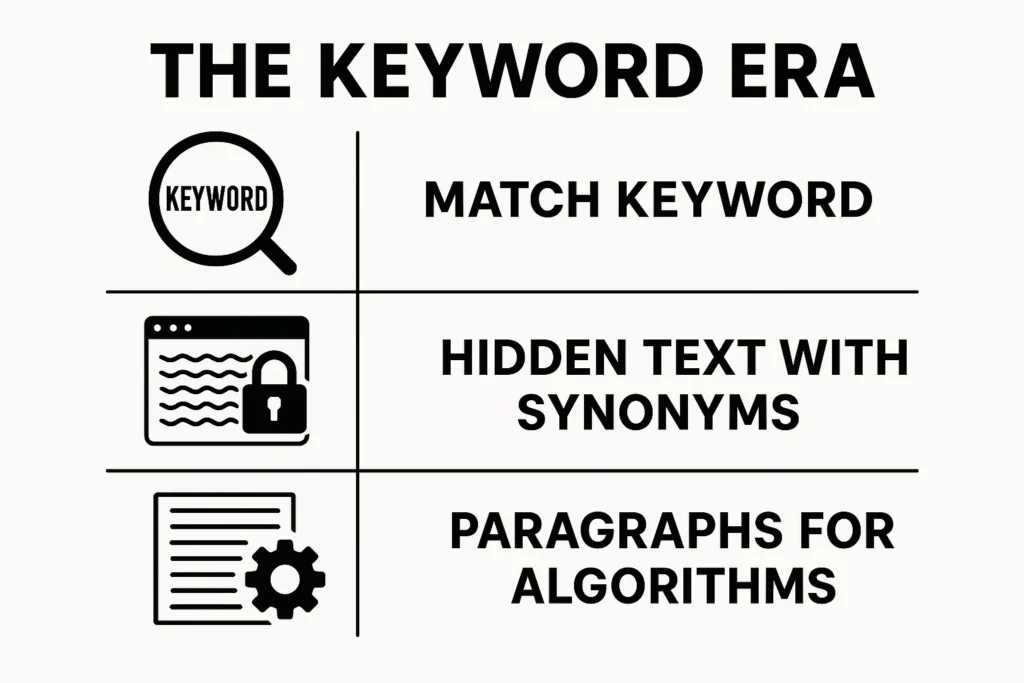

Die Schlüsselwort-Ära: Treffer oder Fehlschlag

Als die Suchmaschinenoptimierung zu einer Sache wurde, entwickelte sich die gesamte Disziplin um diese einfache Einschränkung herum: Suchmaschinen konnten nur das finden, was Sie ihnen vorgaben. Wenn Sie also für "bestes Notebook" ranken wollten, mussten Sie genau diesen Satz in Ihren Inhalt aufnehmen. Vielleicht sogar mehr als einmal.

Dies führte zu einigen bekannten (und fragwürdigen) Praktiken:

- Füllung mit genau passenden Schlüsselwörtern.

- Versteckter Text mit vielen Synonymen.

- Absätze, die für Algorithmen und nicht für Menschen geschrieben werden.

Das hat eine Zeit lang funktioniert. Aber es hat auch das Erlebnis beeinträchtigt. Die Suchergebnisse fühlten sich klobig an. Seiten spielten mit dem System. Und die Suchmaschinen wussten das.

Es musste sich etwas ändern, und das tat es auch.

Risse im System: LSI und die ersten Schritte auf dem Weg zur Semantik

In den 1990er Jahren begannen Forscher mit der Erforschung der Latent Semantic Indexing (LSI). Damit wurde versucht, das Synonym-Problem zu lösen, indem Beziehungen zwischen Wörtern und Dokumenten mathematisch abgebildet wurden.

Die Idee war: Wenn "Auto" und "Automobil" oft in ähnlichen Zusammenhängen vorkommen, könnte das System vielleicht auf ihre Ähnlichkeit schließen.

Theoretisch war die LSI vielversprechend. Aber das war es auch:

- Langsam.

- Empfindlich gegenüber verrauschten Daten.

- Nicht leicht zu aktualisieren.

Letztendlich war es ein cleverer Flicken, aber kein echter Durchbruch.

Ein echter Fortschritt wurde erzielt, als die Suchmaschinen aufhörten, Wörter als Symbole zu behandeln, und begannen, sie als Punkte im Raum zu betrachten.

Eine neue Sprache: Einbettungen und Vektorsuche

Der Durchbruch gelang mit einer täuschend einfachen Idee: "Man erkennt ein Wort an der Gesellschaft, die es führt."

Dieses Zitat des britischen Linguisten J.R. Firth war der Keim für eine Revolution. Wie wäre es, wenn wir Wörter nicht einfach nur betrachten, sondern sie als Vektoren darstellen würden - als Punkte in einem mehrdimensionalen Raum - auf der Grundlage der Wörter, die häufig um sie herum erscheinen?

Word2Vec hat alles verändert

Im Jahr 2013 führte Google Word2Vec ein. Es verstand nicht nur, dass "König" und "Königin" miteinander verwandt waren - es konnte Beziehungen wie diese ableiten:

vector("König") - vector("Mann") + vector("Frau") ≈ vector("Königin")

Das wurde nicht einprogrammiert. Es hat sich ganz natürlich aus dem Training mit großen Textmengen ergeben.

Jetzt hatten die Suchmaschinen eine Möglichkeit, die Bedeutung zu messen. Das konnten sie:

- Dynamische Suche nach Synonymen.

- Verstehen Sie Analogien.

- Erweitern Sie Ihre Suchanfragen ohne künstliche Thesauren.

Von Wörtern zu Sätzen und Dokumenten

Weitere Modelle folgten:

- GloVe (aus Stanford) erfasste globale Co-Occurrence-Statistiken.

- FastText (von Facebook) verbesserte Behandlung von seltenen Wörtern und Tippfehlern.

- Doc2Vec, Universal-Satz-Encoderund Satz-BERT erlaubt die Einbettung ganzer Sätze oder Dokumente.

Und plötzlich waren wir nicht mehr auf der Suche nach Worten. Wir waren auf der Suche nach Bedeutung.

Neuronales Ranking: Relevanz wird intelligenter

Die einbettungsbasierte Suche machte die Dinge besser, aber auch schwieriger zu skalieren. Man konnte nicht alles wegwerfen, was mit invertierten Indizes funktionierte.

Daher haben die großen Suchmaschinen eine hybride Strategie gewählt:

- Verwenden Sie traditionelle lexikalische Methoden (wie BM25), um die ersten 1.000 Ergebnisse zu finden.

- Sie werden anhand von Einbettungen und semantischer Ähnlichkeit neu eingestuft.

Dies bedeutete, dass Ihre Inhalte auch dann abgerufen werden konnten, wenn die Suchanfrage nicht genau Ihre Schlüsselwörter enthielt, solange die Absicht übereinstimmte.

Aus inhaltlicher Sicht war dies eine enorme Veränderung. Es bedeutete:

- Die Relevanz basierte auf der Bedeutung, nicht nur auf der Übereinstimmung von Phrasen.

- Gute Texte und klare Erklärungen können über unbeholfenes Keyword-Stuffing siegen.

Dann kamen die Transformers

Selbst Einbettungen hatten ihre Grenzen. Word2Vec, GloVe und Co. verwendeten feste Vektoren - das Wort "Bank" hatte denselben Vektor, egal ob man "Flussufer" oder "Bankkonto" meinte.

Transformers hat das behoben.

Die 2017 von Vaswani et al. vorgestellte Transformer-Architektur nutzte die Selbstbeobachtung, um zu verstehen, welche Wörter in einem Satz am wichtigsten sind - in beide Richtungen. Jedes Wort hatte eine einzigartige Repräsentation, die auf seinem Kontext basierte.

Dann kam BERT.

Mit BERT (Bidirectional Encoder Representations from Transformers) kann Google den gesamten Kontext einer Suchanfrage verstehen.

Wenn Sie also suchten: "Kann man in der Apotheke Medikamente für jemanden besorgen?", konnte BERT verstehen, dass "für jemanden" die Bedeutung völlig verändert. Vor BERT hätte Google diese Nuance möglicherweise übersehen.

Es half auch bei:

- Passagenbasiertes Abrufen.

- Schnipsel hervorheben.

- Klarheit der Intention bei langen Abfragen.

Das BERT war nicht das Ende der Fahnenstange, aber es hat eine neue Grundlage geschaffen.

Vom Abruf zur Erzeugung: Einzug der LLMs

Während BERT die Art und Weise verbesserte, wie Suchmaschinen Ihre Suchanfragen verstehen, wurde durch einen anderen Innovationsstrom neu gestaltet, was Suchmaschinen mit den Ergebnissen tun können.

Generative Modelle, wie die GPT-Familie, wurden nicht nur entwickelt, um Informationen abzurufen. Sie wurden entwickelt, um sie zu erzeugen.

Retrieval-Augmented Generation (RAG) ist das Modell hinter vielen aktuellen KI-Systemen:

- Finden Sie zunächst die relevanten Dokumente mit Hilfe einer dichten Suche.

- Dann generieren Sie eine flüssige, kontextabhängige Antwort mit Hilfe eines großen Sprachmodells.

Es geht nicht mehr nur darum, das richtige Dokument zu finden. Es geht darum, Fakten aus verschiedenen Quellen zu mischen und sie auf unterhaltsame Weise zu präsentieren.

Was bedeutet das für die Ersteller von Inhalten?

- Ihre Inhalte können verwendet, zitiert oder paraphrasiert werden, auch wenn Sie nie verlinkt werden.

- Sie müssen in der Abrufphase auftauchen, sonst wird das Modell Sie bei der Generierung nicht verwenden.

Multimodale Suche: Jenseits von Text

Eine weitere große Veränderung ist im Gange, und dabei geht es um mehr als nur um Worte.

Das MUM (Multitask Unified Model) von Google wird quer trainiert:

- Text.

- Bilder.

- Videos.

- Audio.

- Sprachen.

Das bedeutet:

- Sie können ein Foto von Wanderschuhen machen und fragen, ob sie für den Berg Fuji im Oktober geeignet sind.

- Das System kann YouTube-Videos, Blogs, Produktseiten und Wanderkarten abrufen - und sie alle verstehen.

Das ändert die Spielregeln für die Suche:

- Alt-Text und Transkriptionen sind wichtiger denn je.

- Strukturierte Daten helfen Maschinen zu verstehen, was Ihr Inhalt ist, nicht nur was er aussagt.

- Die Sprachbarrieren beginnen zu verschwinden.

Effizientes Retrieval in großem Maßstab: Muvera und der nächste Schritt

Als die semantische Suche intelligenter wurde, wurde sie auch schwerer. Die Einbettung jedes Dokuments, der Vergleich jeder Abfrage - das ist sehr rechenintensiv.

Muvera, eine neuere Entwicklung, löst dieses Problem mit Fixed-Dimensional Encodings (FDEs). Diese ermöglichen Systeme:

- Komprimierung von Modellen mit mehreren Vektoren in einzelne, schnell abfragbare Vektoren.

- Erhalten Sie die Qualität des Rankings.

- Verringerung der Latenzzeit und der Serverbelastung.

Für die Nutzer bedeutet dies einfach schnellere und bessere Ergebnisse. Für Suchingenieure bedeutet es eine besser skalierbare Architektur. Für Unternehmen ist es ein weiterer Grund, auf Bedeutung zu optimieren, nicht nur auf Übereinstimmung.

Das neue Playbook für die Sichtbarkeit von Informationen

Wenn Sie bis zu diesem Punkt vorgedrungen sind, hier das große Bild: Wir sind vom String-Matching zum Bedeutungsmatching übergegangen und treten nun in eine Phase ein, in der Inhalte selektiv zu generativen Antworten synthetisiert werden.

Um in dieser neuen IR-Landschaft sichtbar zu bleiben:

- Schreiben Sie für Benutzer, nicht für Schlüsselwörter: Klarheit und Nützlichkeit gewinnen.

- Strukturieren Sie Ihren Inhalt semantischÜberschriften, Schema-Markup und Kontext verwenden.

- Vertiefung der Themen: Die thematische Autorität beeinflusst jetzt die Einbettung der Domäne.

- Denken Sie über Artikel hinausAlt-Text, Videountertitel, Podcast-Zusammenfassungen - all das ist wichtig.

- AI-Übersichten und generative Ausgaben überwachen: Wenn Sie dort nicht auftauchen, verpassen Sie das Gespräch.

Wie Nuoptima in die neue Suchära passt

Unter Nuoptimahaben wir aus erster Hand erfahren, wie sich die Regeln der Suche geändert haben. Die Zeiten, in denen man nach der Keyword-Dichte suchte, sind längst vorbei. Was jetzt zählt, sind Kontext, Absicht und Struktur. Deshalb konzentrieren wir uns auf den Aufbau von Relevanz, nicht nur auf Rankings. Wir helfen Marken nicht nur, in der Suche aufzutauchen - wir helfen ihnen, dort aufzutauchen, wo es zählt: in den Antworten, die KI-Systeme in diesem Moment generieren.

Da sich die Informationsbeschaffung in Richtung semantisches Verständnis, vektorbasierte Suche und multimodale Eingaben verschiebt, entwickelt sich unsere Arbeit mit. Wir kombinieren technische SEO, Linkaufbau und Content-Strategie mit einem scharfen Auge darauf, wie Suchmaschinen wie ChatGPT, Gemini und Perplexity Inhalte abrufen und zusammenfassen. GEO ist für uns kein Modewort - es ist in die Art und Weise integriert, wie wir Sichtbarkeit aufbauen. Wir ermitteln, wie Suchmaschinen Ihre Domain, Ihre Autoren und Ihre thematischen Cluster interpretieren, und optimieren dann von dort aus.

Die Quintessenz? Wir helfen Unternehmen, die neue Sprache der Suche zu sprechen. Ob das nun bedeutet, Kategorieseiten neu zu schreiben, um sie an die Vektorgebiete anzupassen, oder lange Inhalte zu erstellen, die die KI-Zusammenfassung überleben, wir konzentrieren uns auf eine Sache: sicherzustellen, dass Ihre Botschaft dort ankommt, wo Entscheidungen getroffen werden.

Letzte Überlegungen: Suche ist nicht mehr Suche

Was wir "Suche" nennen, hat sich zu etwas viel Größerem entwickelt. Es ist nicht nur ein Werkzeug zum Nachschlagen. Sie ist eine Denkmaschine. Ein Gesprächspartner. Ein Synthesizer für Quellen.

Suchmaschinen versuchen heute nicht nur zu finden, was Sie eingegeben haben. Sie versuchen zu verstehen, was Sie gemeint haben, was relevant ist und wie sie es in einer Form liefern können, mit der Sie tatsächlich etwas anfangen können.

Für Content-Ersteller, SEOs und Vermarkter ist das sowohl eine Herausforderung als auch eine Chance. Denn jetzt geht es bei der Sichtbarkeit nicht mehr nur um das Ranking.

Es geht darum, in die Antwort einbezogen zu werden.

FAQ

Denn der Schlüsselwortabgleich stößt schnell an seine Grenzen. Es ist toll, wenn der Nutzer und der Inhalt genau die gleichen Wörter verwenden, aber das passiert nur selten. Menschen formulieren Dinge auf alle möglichen Arten, und Synonyme, Slang oder sogar Tippfehler können ein strenges Abgleichsystem durcheinander bringen. Durch die Umstellung auf die semantische Suche können die Suchmaschinen verstehen, was die Nutzer meinen, und nicht nur, was sie eingeben.

Einbettungen sind wie Kartenkoordinaten für die Bedeutung. Anstatt Wörter als isolierte Bezeichnungen zu behandeln, verwandeln Suchsysteme sie in Vektoren - Punkte im Raum - basierend auf den Wörtern, in deren Nähe sie erscheinen. So landet "Jaguar" als Auto an einem völlig anderen Ort als "Jaguar" als Tier. Dies hilft den Systemen, den Kontext zu verstehen und Suchanfragen den richtigen Ergebnissen zuzuordnen, auch wenn die Wörter nicht wörtlich übereinstimmen.

Auf jeden Fall, aber nicht im Sinne der alten Schule, in der exakte Phrasen verwendet wurden. Schlüsselwörter dienen jetzt als Signale, Hinweise auf die Absicht der Nutzer und Themencluster. Der Schwerpunkt hat sich verlagert von "wo wiederhole ich dieses Wort?" zu "wie baue ich semantische Tiefe um dieses Konzept herum auf?" Es geht mehr darum, das Thema gut abzudecken als Kästchen abzuhaken.

BERT hilft Google, die Bedeutung von Suchanfragen zu verstehen, insbesondere von solchen, die lang, vage oder wie eine Frage formuliert sind. MUM geht sogar noch weiter: Es ist multimodal, d. h. es kann Bilder und Text zusammen verstehen, und es ist mehrsprachig, d. h. es zieht Erkenntnisse aus Inhalten in jeder Sprache. Es geht darum, die Kluft zwischen dem, was Menschen fragen, und dem, was sie tatsächlich wissen wollen, zu verringern.

Beginnen Sie damit, für Menschen zu schreiben, nicht für Algorithmen. Das klingt offensichtlich, aber es ist überraschend einfach, in die Falle der Überoptimierung zu tappen. Konzentrieren Sie sich auf Klarheit, Struktur und Tiefe. Verwenden Sie Überschriften. Beantworten Sie Fragen. Bieten Sie Kontext. Und denken Sie über die Seite hinaus - Audiotranskripte, Alt-Text und strukturierte Daten füttern jetzt die Maschinen. Sie versuchen nicht nur zu ranken. Sie versuchen, in einer Antwort berücksichtigt zu werden.