KI liefert nicht mehr nur Antworten, sondern schafft sie. Und wenn diese Antwort falsch ist, aber richtig klingt, steht viel auf dem Spiel. Halluzinierte Funktionen, gefälschte Zitate, Meinungen, die als Fakten ausgegeben werden - das ist es, womit Marken, Verlage und Plattformen im Zeitalter der synthetischen Suche konfrontiert sind. GEO Ethics setzt dort an, wo alte SEO-Handbücher versagen. Es geht nicht nur darum, gefunden zu werden - es geht darum, korrekt dargestellt zu werden, bevor die KI etwas in Ihrem Namen erfindet.

Vertrauen, Wahrheit und die unsichtbare Ebene der KI-Suche

Es gibt ein Zitat - das oft mit George Bernard Shaw in Verbindung gebracht wird - das gerade jetzt besonders aktuell erscheint: "Falsches Wissen ist gefährlicher als Unwissenheit."

Das ist im Grunde die Richtung, die wir mit der KI-Suche einschlagen werden.

Als ChatGPT in nur wenigen Monaten 100 Millionen Nutzer erreichte, änderten sich die Regeln des Internets. Suchmaschinen hörten auf, sich wie passive Verzeichnisse zu verhalten, und verwandelten sich in etwas, das einer Konversation ähnelt - eine Konversation, die Antworten im Handumdrehen generiert, manchmal intelligenter, manchmal schneller, oft weniger vorhersehbar.

Und natürlich klang der Ton großartig:

- Sofortige Antworten

- Bessere Entdeckung

- Maßgeschneiderte Ergebnisse

Aber unter der glatten Oberfläche bricht etwas viel Zerbrechlicheres - unser gemeinsamer Sinn für das, was wirklich ist.

Nehmen wir das jüngste Modell-Update von OpenAI. In Benchmark-Tests hat die o3-Version 33% der Zeit halluziniert. Das ist doppelt so hoch wie die Fehlerquote des Vorgängermodells, o1. Und o4-mini? Es war sogar noch schlimmer, da es beim gleichen Test fast die Hälfte der Zeit falsch lag.

Da sich diese Modelle ständig weiterentwickeln, scheint ihre Komplexität mit einem Kompromiss einherzugehen - mehr Halluzinationen. Und das ist ein echtes Problem. Je intelligenter die KI wird, desto selbstbewusster kann sie Antworten geben, die einfach nicht wahr sind. Das zwingt dazu, die Art und Weise, wie diese Systeme getestet und eingeführt werden, zu überdenken.

Als OpenAI im August 2025 GPT-5 auf den Markt brachte, wurde es als großer Sprung nach vorn dargestellt. Die Behauptung? Bis zu 80% weniger Halluzinationen als bei früheren Versionen. GPT-5 führte ein hybrides System ein, das automatisch zwischen einem schnellen Antwortmodus und einer tieferen Denkspur umschaltet - die Idee dahinter ist, dass schwierigere Fragen sorgfältiger bearbeitet werden.

Und OpenAI ist nicht der einzige, der sich um sauberere Ergebnisse bemüht. Google hat sein eigenes System, Gemini 2.5, mit einer Funktion namens AI Mode verfeinert. Statt einmaliger Antworten zerlegt es eine einzige Anfrage in Dutzende kleinerer Fragen, führt parallele Suchen durch und fügt dann eine vollständigere Antwort zusammen.

Die Benchmarks von Drittanbietern zeigen jedoch ein vorsichtigeres Bild. In der Halluzinations-Rangliste von Vectara kommt das GPT-5 auf eine Halluzinationsrate von 1,4% - besser, aber nicht gerade fehlerfrei.

Sicher, 1,4% sehen auf dem Papier besser aus als die 1,491% des GPT-4o, aber sie bleiben immer noch hinter den leistungsstärksten Gemini-Modellen zurück. Und genau das ist der Haken: Was in einem Benchmark-Test solide aussieht, bricht oft zusammen, sobald es in der realen Welt zum Einsatz kommt.

Das ist kein Randthema. KI-generierte Antworten sind inzwischen in Milliarden von Suchanfragen integriert und stehen ganz oben auf der Seite. Die KI-Übersichten von Google haben bereits für Schlagzeilen gesorgt, weil sie selbstbewusst wilde Irrtümer geliefert haben - wie die Behauptung, dass Astronauten Katzen auf dem Mond begegnet sind oder dass wir noch im Jahr 2024 leben.

Diese Ausrutscher mögen auf den ersten Blick lustig erscheinen, aber sie deuten auf etwas Tieferes hin. Wenn falsche Informationen ordentlich verpackt, mit Zuversicht verbreitet und über große Plattformen wiederholt werden, führen sie nicht nur in die Irre - sie bleiben auch haften. Auf diese Weise werden Fehlinformationen normalisiert.

Und für jeden, der in den Bereichen SEO, Inhalte oder digitale Strategie arbeitet, ist diese Veränderung nicht nur akademisch. Sie verändert alles, was wir über Sichtbarkeit zu wissen glaubten.

Bei der Suche geht es immer noch um Relevanz, aber die Regeln haben sich geändert. Die eigentliche Herausforderung besteht nun darin, sichtbar und präzise zu bleiben - und hier kommt die Generative Engine Optimization (GEO) ins Spiel.

GEO baut auf denselben Grundlagen auf, die seit Jahrzehnten die Grundlage für gute Inhalte bilden: Klarheit, Glaubwürdigkeit und Konsistenz. Aber anstatt nur für Menschen oder statische Suchcrawler zu optimieren, passt sich GEO an eine neue Umgebung an - eine, in der Sprachmodelle die Torwächter, Dolmetscher und manchmal sogar die Redakteure Ihrer Botschaft sind.

Bei GEO geht es also nicht nur darum, gesehen zu werden - es geht darum, richtig gesehen zu werden. Es geht darum, Inhalte zu erstellen, die Maschinen überprüfen, darstellen und interpretieren können, ohne den Sinn zu verfälschen.

Das ist der Kern der Sache. GEO ist nicht mehr nur eine Strategie. Es ist ein Schutz in einer Suchlandschaft, in der die Schnittstelle, die Antwort und der Kontext spontan generiert werden - und Ihre Marke ist nur eine KI-Fehlzündung davon entfernt, missverstanden zu werden.

Hinter der GEO-Strategie: Der Ansatz von NUOPTIMA

Unter NUOPTIMAWir beobachten nicht nur, wie sich die KI-Suche weiterentwickelt - wir gestalten auch mit, wie Marken darin auftauchen. Unser Team hat die letzten Jahre damit verbracht, einen forschungsgestützten Ansatz für die Generative Engine Optimization (GEO) zu entwickeln und zu verfeinern, der bereits über 70 Unternehmen dabei geholfen hat, direkt in den KI-generierten Antworten zitiert zu werden. Das bedeutet Sichtbarkeit, wo es am wichtigsten ist - nicht nur auf Seite eins, sondern in der Antwort.

Wir gehen über Rankings hinaus. Bei GEO geht es uns darum, Ihre Inhalte in den Mittelpunkt der Antwort zu stellen. Wenn also Tools wie Googles KI-Übersichten oder ChatGPT eine Antwort liefern, ist Ihre Marke Teil der Geschichte - und wird nicht außen vor gelassen. Von tiefgreifenden Content-Audits bis hin zu maßgeschneiderten KI-Abfrageberichten entwickeln wir Strategien, die darauf abgestimmt sind, wie große Sprachmodelle Informationen tatsächlich verarbeiten.

Wenn Sie sehen möchten, wie wir denken, wie wir arbeiten oder wie wir unseren Kunden helfen, von unsichtbaren zu essentiellen KI-Ergebnissen zu gelangen, nehmen Sie Kontakt mit uns auf LinkedIn. Sie finden hier Fallstudien, Einblicke hinter die Kulissen und Gespräche, die über Schlagworte hinausgehen. Wir sprechen offen darüber, was wir gelernt haben - und was wir noch herausfinden wollen.

Wenn Zitate lügen: Die Glaubwürdigkeitsfalle

Es geht nicht nur darum, dass KI-Modelle sich irren, sondern dass sie dies oft mit vollem Vertrauen tun, verbrämt mit scheinbar seriösen Quellen. Das ist das eigentliche Problem. Man hat es nicht nur mit einer falschen Antwort zu tun - man hat es mit einer falschen Antwort zu tun, die richtig klingt.

Einer der berüchtigten Fälle ereignete sich im Jahr 2024. Die KI-Übersicht von Google forderte die Nutzer auf, eine "Achtel Tasse ungiftigen Klebstoff" in ihre Pizza zu mischen, damit der Käse besser haften bleibt. Klingt absurd - und war es auch. Der Vorschlag stammte direkt aus einem alten Reddit-Witz, der in einem jahrzehntealten Kommentar-Thread vergraben war, aber das System holte ihn hervor und stellte ihn als tatsächlichen Kochtipp dar.

Und das war noch nicht alles. KI-generierte Antworten haben Menschen dazu ermutigt, mit Toastern zu baden, kleine Steine zu essen und anonyme medizinische Ratschläge zu befolgen, die von wer-weiß-wohin zusammengeklaut wurden.

Von harmlosen Fehlern zu Geschäftsrisiken

Diese merkwürdigen KI-Antworten sind nicht einfach nur Bugs - sie deuten auf etwas Tieferes hin. Die Art und Weise, wie große Sprachmodelle trainiert werden, gibt einem zehn Jahre alten Reddit-Witz und einer von Experten begutachteten medizinischen Studie das gleiche Gewicht. Kein echter Filter. Keine Hierarchie. Wenn diese Systeme also "zitieren", imitieren sie oft eine Autorität, ohne auch nur annähernd zuverlässige Informationen zu liefern. Und die Folgen gehen weit über alberne Pizzarezepte hinaus.

Hier besteht ein echtes Geschäftsrisiko - vor allem für Marken, die keinen starken digitalen Fußabdruck aufgebaut haben. Wenn Sie online nicht eindeutig vertreten sind, besteht die Gefahr, dass Sie durch veraltete Beiträge, oberflächliche Aufnahmen oder subtile Angriffe der Konkurrenz definiert werden. Nehmen wir an, eine SaaS-Marke verfügt nicht über solide Bottom-of-Funnel-Inhalte. Ein Konkurrent könnte einen "Vergleich" veröffentlichen, der das Unternehmen als klobig oder überteuert darstellt. Die künstliche Intelligenz greift dies auf, wiederholt es, als wäre es Konsens, und plötzlich ist dies die Erzählung, die die Benutzer zuerst sehen.

Wenn KI erfindet, was es nicht gibt

Wenn diese Art von Erzählung ihren Weg in etwas wie Googles KI-Übersicht oder eine ChatGPT-Antwort findet, bleibt sie nicht nur ein Einzelfall. Sie wird wiederholt, als wäre sie eine Tatsache - nicht weil sie verifiziert wurde, sondern weil das System ein vertrautes Muster entdeckt hat. Und dieses Muster kann aus einem einzigen Blogbeitrag, einem fünf Jahre alten Kommentar-Thread oder einer negativen Bewertung ohne Kontext stammen. Was als Meinung beginnt, wird zu einer "vertrauenswürdigen" KI-Anleitung - oft, bevor der Nutzer überhaupt auf Ihrer Website gelandet ist.

Manchmal wird es noch merkwürdiger. Diese Modelle verstärken nicht nur fehlerhafte Eingaben - sie erfinden Dinge von Grund auf neu.

Ein gutes Beispiel? Soundslice, eine SaaS-Plattform für das Erlernen von Musik, erhielt Fehlermeldungen im Zusammenhang mit etwas Seltsamem: Benutzer luden ASCII-Gitarren-Tabs hoch, nachdem ihnen von ChatGPT mitgeteilt worden war, dass Soundslice sie in Audio umwandeln könne. Das Problem ist, dass diese Funktion nie existierte. Die KI hatte sie erfunden - und die Nutzer glaubten ihr.

Es stellte sich heraus, dass ChatGPT die Benutzer aufforderte, sich bei Soundslice anzumelden und ASCII-Tabs hochzuladen, um eine Audiowiedergabe zu erhalten. Ein Problem - diese Funktion existierte nicht. Die KI hatte sie aus dem Nichts erfunden. Die Nutzer kamen also mit Erwartungen an, die das Produkt nicht erfüllen konnte, und das Unternehmen schien zu viel versprochen zu haben.

Anstatt sich zu wehren, baute das Soundslice-Team die Funktion nur, um mit der Verwirrung Schritt zu halten. Der Gründer Adrian Holovaty nannte es eine praktische Entscheidung - gab aber auch zu, dass es sich so anfühlte, als ob die Produkt-Roadmap durch falsche Informationen unterwandert worden wäre.

Warum GEO unverzichtbar geworden ist

Dies ist das größere Problem. Wenn KI-Antworten als Standardzugang zu Ihrer Marke fungieren, kann selbst die kleinste Verzerrung zu einem Schneeball werden. Egal, ob es sich um veraltete Informationen handelt, um den Einfluss von Wettbewerbern oder um etwas, das sich das Modell einfach ausgedacht hat, das Risiko ist dasselbe: Ihr Unternehmen wird falsch dargestellt, bevor jemand Ihre Website überhaupt erreicht.

Einer der größten blinden Flecken bei generativen Modellen ist ihre völlige Missachtung von Absicht, Glaubwürdigkeit der Quelle oder realem Kontext. Sie sind nicht dazu da, die Qualität zu beurteilen, sondern um Muster zu erkennen. Und genau da fangen die Dinge an, auseinanderzufallen.

- Diese Systeme klingen autoritär, ohne tatsächlich korrekt zu sein.

- Sie ziehen Zitate heran, interpretieren sie aber oft falsch.

- Sie beziehen sich auf reale Daten, lassen aber die Haftungsausschlüsse weg.

- Sie geben Antworten, die sich ausgefeilt anfühlen, während sie die Wahrheit leise verbiegen.

- Und das Schlimmste ist, dass sie das alles sagen, als wären sie sich 100% sicher.

Wenn diese Art von Output die Suchergebnisse überflutet, sind die nachgelagerten Effekte kaum zu übersehen. Marken werden falsch dargestellt. Verlage verlieren ihr Publikum. Faktenchecker können nicht mithalten. Und all diese fehlerhaften Inhalte? Sie landen wieder in den Trainingsdaten, die das nächste Modell füttern und die gleichen schlechten Gewohnheiten festschreiben - nur in größerem Umfang.

An diesem Punkt wird GEO von hilfreich zu wichtig. Sie versuchen nicht mehr nur, gesehen zu werden - Sie versuchen sicherzustellen, dass die Version Ihrer Marke, die angezeigt wird, tatsächlich korrekt ist. Wenn Sie die Eingaben nicht selbst gestalten, wird das System die Ausgabe für Sie gestalten - und das Ergebnis wird Ihnen wahrscheinlich nicht gefallen.

Das Problem der Halluzinationen geht nicht weg

Als die künstliche Intelligenz begann, Texte zu erzeugen, die menschlich klangen, war das wie ein Durchbruch. Heute ist genau diese Stärke eine ihrer größten Schwächen. Was Forscher höflich als "Halluzinationen" bezeichnen, sind im Klartext sichere Fehler - falsche Antworten, die richtig klingen und sich schnell verbreiten.

Und das Schlimmste daran? Diese Ausgaben wirken nicht nur glaubwürdig - sie imitieren oft den Ton, die Struktur und die oberflächliche Autorität von echten Informationen. Sie fühlen sich vertraut an. Sie lassen sich nur schwer spontan auf Fakten überprüfen. Und das macht sie besonders gefährlich.

Rechtliche und medizinische Konsequenzen

Das ist auch kein Randthema. Eine gemeinsame Studie von Stanford und anderen akademischen Gruppen ergab, dass KI-gestützte juristische Recherchetools - auch von großen Anbietern wie LexisNexis und Thomson Reuters - in 17% bis 33% ihrer Antworten halluzinieren.

In der Welt des Rechts zeigen sich diese Halluzinationen auf zwei gefährliche Arten: Entweder gibt die KI das Gesetz völlig falsch an, oder sie zitiert eine rechtmäßige Vorschrift, fügt aber die falsche Quelle hinzu. Die zweite Variante könnte sogar noch schlimmer sein, denn sie führt Nutzer in die Irre, die sich darauf verlassen, dass das System sie auf etwas Glaubwürdiges hinweist.

Auch das Gesundheitswesen ist nicht immun. Selbst bei gut trainierten Modellen können die Halluzinationsraten bei medizinischen Zitaten je nach Aufgabe von 28% bis zu 90% reichen. Das mag auf den ersten Blick nicht beunruhigend klingen - bis man sich vor Augen führt, dass diese Systeme Milliarden von Abfragen bearbeiten. In großem Maßstab werden diese "geringen" Fehlerquoten täglich zu Dutzenden von Millionen irreführender oder sogar schädlicher Ergebnisse.

Halluzinationen in Suchergebnissen

Und das bleibt nicht mehr nur in Randbereichen verborgen. KI-Antworten sind jetzt in die allgemeine Suche integriert. Da immer mehr KI-generierte Inhalte direkt in den SERPs erscheinen, werden diese Halluzinationen Teil der Standard-Erfahrung für alltägliche Nutzer.

Im März 2025 zeigten die Daten von Semrush, dass 13,14% aller Google-Suchanfragen eine KI-Übersicht auslösten - fast doppelt so viel wie nur zwei Monate zuvor. Der Anstieg war in den sensibelsten Bereichen am stärksten: Gesundheitswesen, Recht, Regierung, Wissenschaft und soziale Themen. Die Bereiche, in denen man sich keine Fehler leisten kann.

Warum die Risiken zunehmen

Nach Ansicht des Semrush-Analysten ist es ein mutiger Schritt von Google, KI-Übersichten so aggressiv in Bereichen wie Gesundheit, Recht und Wissenschaft einzuführen - Bereiche, in denen Antworten oft umstritten sind und die Fehlertoleranz gering ist. Dies sind Branchen, die bereits mit Fehlinformationen zu kämpfen haben und mit einer Vielzahl von Vorschriften belastet sind.

Google mag glauben, dass die Modelle genau genug sind. Aber die Realität ist komplizierter. Da immer mehr Nutzer beginnen, KI-generierten Zusammenfassungen zu vertrauen, ohne sie zu hinterfragen, wächst das Potenzial für die Verbreitung falscher Informationen schnell - und in großem Umfang.

Das bringt uns in eine verzwickte Lage

Traditionelle Suchmaschinenoptimierung basierte auf Relevanz, Glaubwürdigkeit und eindeutigen Signalen von Autorität. Aber KI-generierte Ergebnisse mischen Inhalte oft auf eine Art und Weise neu, die den Kontext verwischt oder die ursprüngliche Absicht völlig verfehlt.

Sie werden vielleicht trotzdem zitiert - aber nicht so, wie Sie es sich wünschen. Vielleicht erscheint Ihre Marke in der Ausgabe, aber der Rahmen stimmt nicht, oder wichtige Fakten sind verzerrt. Und sobald diese Version auf der Seite erscheint, wird sie zur neuen Standardversion für alle, die sie sehen.

Hier kommt GEO ins Spiel. Es ist kein Wundermittel gegen Halluzinationen, aber es ist eine Möglichkeit, den Schaden zu verringern. Bei GEO geht es darum, bewusst zu handeln - mit Struktur, Klarheit und faktischen Signalen, um KI-Systeme zur richtigen Interpretation Ihrer Inhalte zu führen und nicht zu einer verzerrten.

In der Praxis könnte das so aussehen:

- Das Verfassen von Inhalten, die ihre Absicht kristallklar machen - keine Zweideutigkeit, kein Raum für Fehlinterpretationen

- Untermauerung der wichtigsten Punkte mit starken faktischen Signalen wie vertrauenswürdigen Zitaten, strukturierten Daten und richtig gekennzeichneten Entitäten

- Denken wie das Modell: Verstehen, wie LLMs Sprache anders verarbeiten als Menschen oder sogar herkömmliche Suchroboter

Wenn Sie Ihre Inhalte daraufhin optimieren, wie Maschinen sie interpretieren - und nicht nur, wie Menschen sie sehen -, erhöhen Sie die Wahrscheinlichkeit, dass das, was in einer KI-Zusammenfassung auftaucht, tatsächlich das widerspiegelt, was Sie gemeint haben. Das ist das Herzstück von GEO. Es gibt Ihnen die Möglichkeit, sich zu wehren und das System zu etwas zu führen, das der Wahrheit näher kommt.

Nein, es ist nicht kugelsicher. Aber es ist ein Puffer. Und in einer Welt, in der KI unweigerlich Fehler macht, könnte dieser Puffer das Einzige sein, was zwischen Ihrem Publikum und einer Version Ihrer Marke steht, die einfach nicht real ist.

Regulierung und die Transparenzlücke bei der KI-Suche

Die KI-Suche hat eine neue Art von Undurchsichtigkeit ins Spiel gebracht. Man tippt eine Frage ein, erhält eine selbstbewusste, gut formulierte Antwort zurück - und die meisten Menschen werden nicht zweimal darüber nachdenken, woher sie kommt. Das System fühlt sich menschlich an, aber die Quelle? Oft fehlt sie, ist verschüttet oder so dünn geschnitten, dass es unmöglich ist, sie zurückzuverfolgen.

Selbst wenn Zitate auftauchen, sind sie meist in Dropdowns versteckt oder nur vage mit einem Teil der Antwort verknüpft, nicht mit dem Ganzen. Die Antwort der KI klingt ausgefeilt und vollständig, was es leicht macht, die Quelle ganz zu ignorieren - wenn sie überhaupt sichtbar ist.

Das ist der Punkt, an dem das Vertrauen zu schwinden beginnt. Das Modell klingt selbstsicher, aber das Fundament, auf dem es steht, ist nicht immer solide. Und die Nutzer haben selten die Mittel oder den Kontext, um den Unterschied zu erkennen.

Wir sind in eine Ära eingetreten, in der KI nicht nur die Wahrheit vermittelt, sondern sie auch umsetzt. Und dieser Wandel zwingt die Transparenz von einem Nice-to-have zu einer strukturellen Notwendigkeit. Wenn sich die Menschen auf KI-generiertes Wissen verlassen wollen, müssen die Systeme dahinter ihre Logik sichtbar machen.

Eine der wenigen Orientierungshilfen, die wir derzeit haben, sind die Search Quality Rater Guidelines von Google. Für SEO-Teams sind sie das, was einem öffentlichen Rahmen am nächsten kommt, vor allem, weil sie den Schwerpunkt auf E-E-A-T legen: Erfahrung, Kompetenz, Autorität und Vertrauenswürdigkeit.

Der Bedarf an Genauigkeit ist bei Themen wie Gesundheitswesen, Finanzen, Rechtsberatung und allem, was mit staatlichen Verfahren zu tun hat, nicht verhandelbar. Dies sind die Bereiche, in denen KI-Halluzinationen in der realen Welt schnell Schaden anrichten können.

Suchplattformen prüfen intern, wie zuverlässig ihre Ergebnisse sind. Aber von der Nutzerseite aus ist nichts davon sichtbar. Es ist nicht ersichtlich, wie eine Antwort generiert wurde, woher die Daten stammen oder wie zuverlässig das System tatsächlich ist. Daher behandeln die Menschen KI-Antworten als Fakten - obwohl es sich in Wirklichkeit oft nur um Vermutungen handelt, die als Gewissheit ausgegeben werden.

Das ist der Grund, warum GEO so wichtig ist

Es ist nicht mehr nur eine Reaktion auf das veränderte Suchverhalten - es wird zu einem proaktiven Rahmen, der Transparenz in den Vordergrund stellt.

In diesem Zusammenhang bedeutet Transparenz, Inhalte zu erstellen, die für sich selbst sprechen können. Aus den Seiten sollte klar hervorgehen, woher die Informationen stammen, warum sie vertrauenswürdig sind und wo die Grenze zwischen Beweisen und Meinungen verläuft. Schema-Markup und strukturelle Hinweise sind nicht nur technische Spielereien - sie helfen Maschinen, solide Fakten von Spekulationen zu unterscheiden.

Dies sind nicht mehr nur Checklisten für bewährte Praktiken - sie sind die neue Grundlage, um online sichtbar zu bleiben. Wenn Ihre Inhalte nicht so aufgebaut sind, dass sowohl Menschen als auch Maschinen sie sofort als vertrauenswürdig erkennen können, werden sie wahrscheinlich untergehen. Das bedeutet, dass Sie eindeutige Zitate direkt in den Text einfügen, echte Autorenbiografien einfügen, die das Fachwissen belegen, und strukturierte Daten verwenden, um genau zu kennzeichnen, was Ihre Inhalte sind und für wen sie bestimmt sind.

Hier geht es nicht um Theorie, sondern um konkrete Daten. Google achtet auf Originalität, Autorensignale und Engagement-Metriken. Wenn Sie also ethische, transparente Inhaltspraktiken anwenden, geht es nicht nur darum, das Richtige zu tun. Es geht auch darum, wie Sie an Sichtbarkeit gewinnen.

Das Problem dabei? Die KI-Suche hält sich nicht immer an diese Regeln. Zurzeit müssen Plattformen nicht angeben, wie eine Zusammenfassung erstellt wurde, auf welche Quellen sie sich stützt oder warum eine Interpretation einer anderen vorgezogen wurde. Es gibt keinen vorgeschriebenen Prüfpfad. Das bedeutet, dass ein Startup, das akkurate, überprüfbare Inhalte veröffentlicht, immer noch von einem Modell, das auf veralteten oder minderwertigen Quellen basiert, überholt - oder falsch zitiert - werden kann.

Und das ist das größere Problem. In diesem Umfeld ist Transparenz nicht nur ein Nice-to-have - sie ist grundlegend. Wenn KI kontrolliert, was Nutzer sehen, was hervorgehoben wird und wie Inhalte gestaltet werden, können wir nicht mehr nur für menschliche Leser entwickeln. Wir müssen auch für Maschinen bauen - und zwar auf eine Weise, die nachvollziehbar, konsistent und schwer zu verfälschen ist.

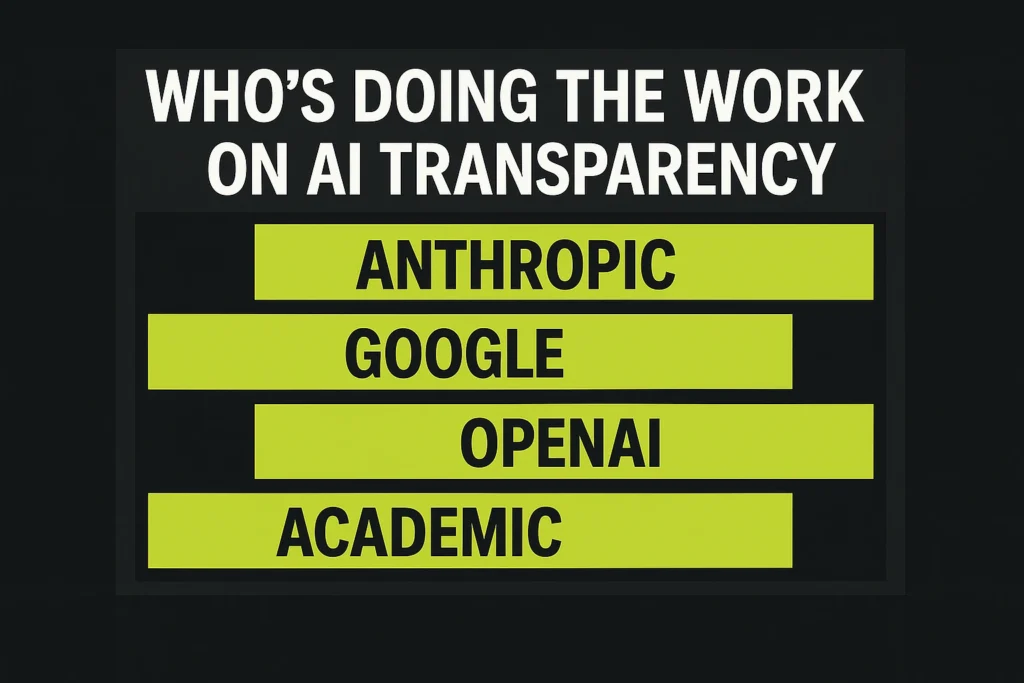

Einige der großen Akteure haben begonnen, darauf zu reagieren. Unternehmen wie Anthropic, OpenAI und Google investieren jetzt in die Transparenzforschung und veröffentlichen Sicherheitsrahmenwerke. Für alle, die verstehen wollen, wie diese Systeme funktionieren - und wo die Leitplanken sind -, stehen bereits eine Handvoll wichtiger Ressourcen zur Verfügung.

Wer kümmert sich eigentlich um die KI-Transparenz?

Wenn Sie sich einen Überblick darüber verschaffen möchten, wie die wichtigsten Akteure Sicherheit und Verantwortlichkeit in der KI angehen, finden Sie hier eine kurze Übersicht darüber, worauf Sie achten sollten - und worauf sich jede Gruppe konzentriert.

1. Anthropisch

- Forschung: untersucht, wie ihre Modelle funktionieren, welche Risiken sie bergen und wie sie sich auf die Gesellschaft auswirken

- Transparenz-Drehscheibe: Aufschlüsselung der internen Prozesse und der Grundsätze für ihre verantwortungsvolle KI-Entwicklung

- Trust Center: Verfolgt, wie sie mit Sicherheit, Compliance und Datenschutz umgehen

2. Google

- KI-Forschung: Deckt alles ab, von grundlegenden Modellen bis hin zu angewandten Projekten zum maschinellen Lernen in verschiedenen Bereichen

- Verantwortliche KI: Fokus auf Fairness, Inklusion und ethische Nutzung von KI

- KI-Sicherheit: Untersucht, wie man Produkte sicher und geerdet halten kann, wenn KI im gesamten Google-Ökosystem skaliert

3. OpenAI

- Forschung: Dokumentiert die laufenden Arbeiten zur Verbesserung der Modellleistung und -fähigkeit

- Sicherheit: Erläutert, wie OpenAI das Systemverhalten auswertet und Risiken bei verschiedenen Einsätzen behandelt

4. Akademisch

- arXiv.org: Die zentrale Plattform für frei zugängliche KI-Forschungsarbeiten, Preprints und technische Erkenntnisse aus der weltweiten akademischen Gemeinschaft

Diese Tools und Ressourcen helfen, den Vorhang über die Funktionsweise von KI-Systemen zu lüften. Aber das Wissen, wie sie funktionieren, ist nur der Anfang.

Blick nach vorn: Was kommt als Nächstes?

Eine der größten Fragen, vor denen wir jetzt stehen, ist, ob wir die Art und Weise, wie die KI-Suche funktioniert, selbst gestalten - oder ob wir zulassen, dass sie unsere Sicht auf die Welt bestimmt. Dabei geht es um weit mehr als um Rankings und Traffic. Wenn wir es falsch anpacken, riskieren wir, die Zukunft auf einem Fundament aus Fehlinformationen und Vermutungen aufzubauen.

Wir stehen also vor der Wahl. Wir können die KI-Suche weiterhin wie ein System behandeln, das man ausnutzen kann - ein Spiel, das man spielen kann - oder wir können sie als die ethische Herausforderung behandeln, die sie tatsächlich ist. GEO und Relevance Engineering sind nicht nur neue Schlagworte. Sie bilden die Grundlage für den Aufbau von Informationssystemen, die genau, transparent und in großem Umfang tatsächlich nützlich sind.

Die Algorithmen, die diese Systeme steuern, mögen zwar verborgen sein, aber ihr Einfluss auf unsere Überzeugungen - und unser Verhalten - ist sehr real. Um in diesem neuen Bereich erfolgreich zu sein, muss man über technische SEO hinausgehen. Es bedeutet, sich zu Klarheit, Verantwortlichkeit und Wahrheit zu verpflichten.

Denn in einer Welt, in der Maschinen zwischen der Frage und der Antwort stehen, reicht es nicht aus, auffindbar zu sein. Man muss auch vertrauenswürdig sein. Und das ist kein netter Bonus mehr - es ist die Grundlage.

FAQ

Die traditionelle Suchmaschinenoptimierung konzentriert sich auf die Optimierung für Suchmaschinen, die statische Ergebnisse auf der Grundlage von Schlüsselwörtern, Links und Seitensignalen anzeigen. GEO, oder Generative Engine Optimization, ist eine Antwort auf die KI-gesteuerte Suche, bei der Antworten dynamisch durch Sprachmodelle erstellt werden. Bei GEO geht es nicht nur um Rankings, sondern auch darum, dass Ihre Inhalte richtig interpretiert, fair zitiert und nicht durch synthetische Zusammenfassungen verzerrt werden.

Denn wenn KI-Systeme beginnen, das Internet in Echtzeit umzuschreiben, liegen die Stimme, die Genauigkeit und die Glaubwürdigkeit Ihrer Marke nicht mehr vollständig in Ihrer Kontrolle. Bei GEO Ethics geht es darum, diese Verantwortung zu übernehmen und dafür zu sorgen, dass die von Ihnen erstellten Inhalte klar, überprüfbar und schwer zu verfälschen sind. Es geht nicht darum, das System zu manipulieren. Es geht darum, die Wahrheit in einem Umfeld zu schützen, in dem Vertrauen oft wichtiger ist als Korrektheit.

Nicht ganz. Die Qualität der Inhalte ist immer noch wichtig, aber GEO fügt eine weitere Ebene hinzu: wie Maschinen diese Inhalte verstehen. Eine Seite kann sich für einen Menschen gut lesen, aber ein Sprachmodell verwirren, wenn es ihr an Struktur, Signalen oder Klarheit mangelt. GEO überbrückt diese Lücke, indem es die Qualität in etwas übersetzt, mit dem KI-Systeme tatsächlich arbeiten können.

Nein. Halluzinationen sind ein eingebautes Risiko bei generativen Systemen - sie werden Dinge erfinden. Aber GEO gibt Ihnen die Möglichkeit, die Wahrscheinlichkeit zu verringern, dass Ihre Inhalte falsch zitiert, falsch dargestellt oder komplett erfunden werden. Betrachten Sie es weniger als Problemlösung und mehr als Filter. Wenn Sie nicht beeinflussen können, was reinkommt, sind Sie dem ausgeliefert, was erfunden wird.