Die Suche verändert sich schneller, als die meisten Unternehmen mit ihr Schritt halten können. Das alte Spiel der Jagd nach Rankings durch Schlüsselwörter wird durch etwas Größeres ersetzt: KI-Assistenten, die für die Nutzer denken, sprechen und handeln. Diese Veränderung nennen wir Generative Engine Optimization (GEO). Es geht darum, Ihre Inhalte und Ihre Strategie auf eine Welt vorzubereiten, in der das "Suchfeld" kaum noch existiert, die Entdeckung aber immer noch das Wachstum antreibt.

Entdeckung neu denken: KI-gestützte Suche und der Aufstieg von GEO

Die Suche durchläuft einen merkwürdigen Wandel - einen Wandel, bei dem es kein klares Vorher und Nachher gibt. Es geht nicht mehr nur darum, Wörter in ein Feld einzutippen und durch eine Liste von Links zu scrollen. Diese Ära liegt größtenteils hinter uns.

Was uns heute bleibt, ist eine unübersichtliche Version von Google, vollgepackt mit KI-Unschärfe, ununterbrochener Werbung, Snippets, die Ihre Frage beantworten, bevor Sie überhaupt klicken, und ein schrumpfender Anteil echter organischer Ergebnisse. Plattformen wie ChatGPT und AI Mode betrachten die Suche nicht als Ziel, sondern nur als eine Funktion innerhalb eines umfassenderen Assistentenerlebnisses.

In Zukunft wird der Wandel noch dramatischer ausfallen. Die Menschen werden vielleicht nicht mehr so "suchen", wie wir es bisher kannten. Anstatt eine Suchmaschine zu öffnen, werden sie einfach ihren KI-Assistenten fragen - und ihn in aller Ruhe für sie graben lassen. Dieser Wandel ist nicht erst in einigen Jahren zu erwarten - er ist bereits im Gange. Mit Tools wie Googles Project Mariner und Astra sowie den großen Schritten von OpenAI, Amazon und Meta treten wir in die nächste Phase der Entdeckung ein: eine Phase, die auf KI basiert und von dem angetrieben wird, was wir heute Generative Experience Optimization (GEO) nennen.

Von Rankings zu Relevanz: Der NUOPTIMA GEO-Ansatz

Unter NUOPTIMAWir sprechen nicht nur über den KI-Wandel - wir bauen dafür. Generative Engine Optimization (GEO) ist kein Trend, dem wir hinterherlaufen. Es ist ein Spielbuch, das wir durch praktisches Experimentieren und eigene Forschung entwickelt haben. Während SEO darauf abzielt, durch Rankings Sichtbarkeit zu erlangen, geht es bei GEO darum, selbst zur Antwort zu werden - der Inhalt, den KI liefert, wenn sie auf die Frage eines Nutzers antwortet.

Unser Team ist auf diesen Wandel ausgerichtet. Wir erstellen aussagekräftige, KI-lesbare Inhalte, bilden High-Intent-Anfragen ab und verfolgen die Metriken, die in dieser neuen Suchlandschaft tatsächlich von Bedeutung sind - Dinge wie Assistenzzitate, direkter Traffic von KI-Maschinen und Lead Flow, der durch intelligente Content-Positionierung angetrieben wird. Das ist keine Theorie. Es ist eine durch Ergebnisse untermauerte Ausführung.

Wir sind auch nicht schwer zu finden. Wir tauschen uns offen über unsere Forschung aus und sind immer zu einem Gespräch bereit - Sie können mit uns Kontakt aufnehmen unter LinkedIn.

KI-gesteuerte Entdeckungen und die Realitäten von GEO

Bei GEO in seiner fortgeschrittenen Form geht es weniger um Regeln als vielmehr um das Management von Wahrscheinlichkeiten. Nichts bleibt für lange Zeit fest. Die Systeme, die die KI-Suche antreiben, sind immer noch im Fluss - was heute noch funktioniert, kann morgen schon nicht mehr funktionieren.

Das ist die Art von Landschaft, in der wir uns bewegen:

- An einem Tag können KI-Crawler kein JavaScript verarbeiten - am nächsten Tag können sie es plötzlich.

- In der einen Woche stützt sich OpenAI auf die Suchindizes von Google und Bing, in der nächsten baut es im Stillen seinen eigenen auf.

- In einem Moment ist Ihre Website das primäre Zuhause für Ihre Inhalte - im nächsten ist sie nur noch eine Datenquelle für den Speicher einer KI.

Es gibt keinen festen Boden. Aber wir beginnen, Muster zu erkennen. Und wenn Sie aufmerksam sind, können diese Signale dazu beitragen, Ihre Inhalte - und Ihr Unternehmen - auf das vorzubereiten, was als Nächstes kommt.

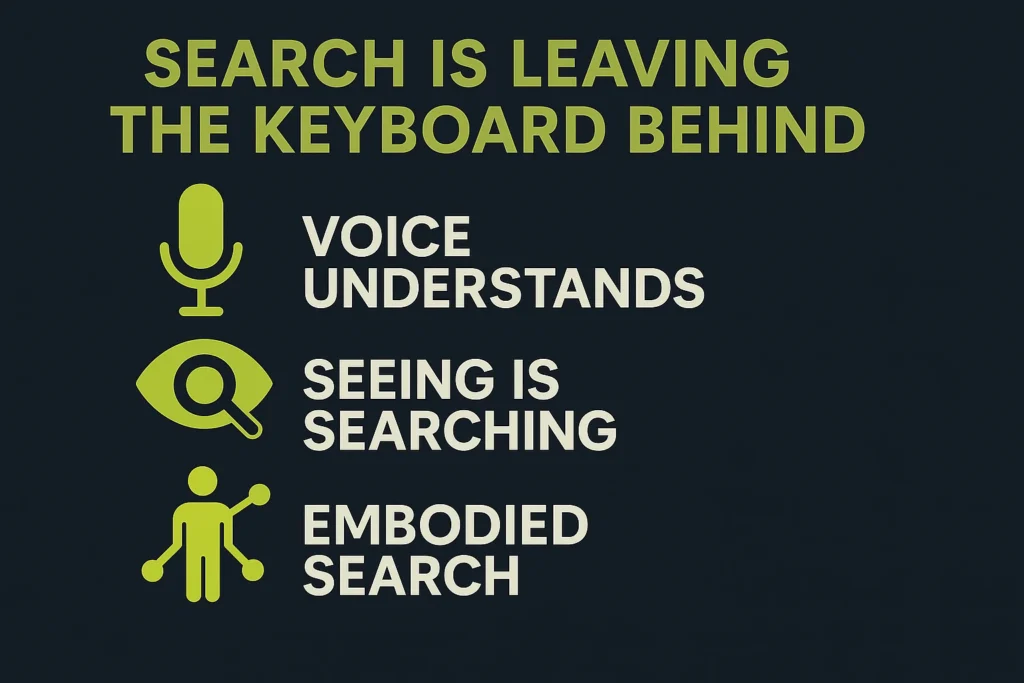

Die Suche lässt die Tastatur hinter sich

Eine der größten Veränderungen in der Art und Weise, wie wir Informationen finden, vollzieht sich im Stillen - wir tippen nicht mehr. Obwohl wir jahrzehntelang an Tastaturen geklebt haben, war das Tippen schon immer ein gewisser Engpass. Es ist nicht die Art, wie wir denken. Es ist langsamer als Sprechen, Zeigen oder einfach nur... Schauen.

Hier kommen die sprachgesteuerte, visuelle und sogar die verkörperte Suche ins Spiel. Dies sind keine futuristischen Ideen mehr - sie verändern bereits die Art und Weise, wie Menschen mit KI interagieren. Sie könnten mit einem Assistenten sprechen, ihm zeigen, was Sie sehen, oder ein tragbares Gerät verwenden, das die Welt um Sie herum ständig in Echtzeit interpretiert.

Stimme, die versteht, nicht nur antwortet

Die Sprachsuche ist in SEO-Kreisen schon seit Jahren eine Pointe, aber seien wir ehrlich - sie ist bereits überall. Siri, Alexa, Google Assistant - sie befinden sich in den Wohnungen, Taschen und Autos der Menschen. Was sich geändert hat, ist, dass die nächste Generation der KI Sprachschnittstellen viel intelligenter und nützlicher macht.

Nehmen Sie Googles Projekt Astra. Es ist nicht nur eine Sprachsuche, sondern ein echter Dialog. Es versteht verschiedene Akzente, antwortet in 24 Sprachen und führt ein Gespräch in Echtzeit. Das ist ein ganz anderes Spiel.

Mit dieser neuen Generation der Sprachtechnologie geht alles fast mühelos. Sie können vielschichtige, offene Fragen stellen, als ob Sie mit jemandem sprechen würden, der Sie tatsächlich versteht - und Sie erhalten sofort eine Antwort, die mit Kontext versehen ist. Amazons aktualisiertes Alexa+ geht sogar noch einen Schritt weiter. Es ist nicht nur reaktiv - es ist dialogorientiert. Sie können Ihren Zeitplan planen, nach Produkten suchen oder einfach nur über Ideen plaudern - und das alles, ohne einen Finger zu rühren.

Wenn die Sprache von umfangreichen Sprachmodellen unterstützt wird, fühlt sich die Suche nicht mehr wie eine Befehlszeile an, sondern eher so, als würde man mit einem intelligenten Freund Ideen austauschen.

Sehen ist Suchen

Die visuelle Suche geht in die gleiche Richtung. Wir sind bereits an einem Punkt angelangt, an dem Sie Ihr Telefon - oder eine intelligente Brille - auf etwas richten und einfach fragen können, was es ist. Google hat hier große Anstrengungen unternommen: Die Linse kann bereits Objekte erkennen, Text aus Bildern lesen und Zeichen in Echtzeit übersetzen. Aber mit Project Astra werden die Dinge noch dynamischer.

Wenn Sie Astra im "Live"-Modus verwenden, können Sie eine Taste drücken und Fragen zu allem stellen, was Sie in Ihrem Kamera-Feed sehen - die KI sieht, was Sie sehen und antwortet sofort. Fragen Sie nach einem Gebäude, einem Produkt oder sogar einem Rezept, das Sie gerade kochen - und Astra antwortet in Echtzeit.

Entdeckungen finden nicht mehr nur auf Bildschirmen und in Suchleisten statt, sondern immer öfter auch in der realen Welt. Stellen Sie sich vor: Sie betrachten ein Gebäude, und Ihre intelligente Brille erzählt Ihnen seine Geschichte. Oder Sie scannen ein Produkt in einem Regal, und Ihre KI sucht nach Bewertungen, Preisvergleichen und weist Sie vielleicht sogar auf ein besseres Angebot in der Nähe hin. Die Suche funktioniert jetzt nicht mehr nur über Text, sondern auch über das Sehen.

Wie die verkörperte Suche aussieht

So sieht die verkörperte Suche aus. Es geht nicht nur um Sprache oder Bilder - es geht darum, dass Ihr Assistent Ihre Umgebung wahrnimmt. Geräte wie AR-Brillen machen das möglich. Der Prototyp von Google, der aus der Arbeit an Project Astra hervorgegangen ist, kann die Welt aus Ihrer Perspektive betrachten und hilfreiche Informationen direkt auf das einblenden, was Sie sehen - in Echtzeit.

In dieser Konfiguration ist die KI kein Werkzeug, das Sie aufrufen - sie ist eher wie ein Co-Pilot, der sich mit Ihnen bewegt. Sie kann beschreiben, was vor Ihnen liegt, Sie durch eine Aufgabe leiten oder bei Bedarf sogar Unterstützung leisten. Stellen Sie sich einen sehbehinderten Benutzer vor, der beim Gehen vor Hindernissen gewarnt wird, oder jemanden, der ein neues Rezept kocht und währenddessen Anweisungen zu den Zutaten erhält. Es ist eine Suche, die in dem Moment auftaucht - ohne dass man zweimal fragen muss.

All diese neuen Interaktionsmöglichkeiten - Sprechen, Zeigen, Scannen - drängen die Suchmaschinen in ungewohntes Terrain. Sie sind gezwungen, mehr als nur Text zu verstehen.

Um mithalten zu können, müssen Suchsysteme jetzt Bilder, Videos, Ton und sogar 3D-Eingaben genauso flüssig interpretieren können wie Sprache. Für SEOs und Vermarkter ist das eine echte Veränderung. Es reicht nicht mehr aus, Überschriften und Metadaten zu optimieren. Jetzt müssen Sie sich auch Gedanken darüber machen, wie Ihre Inhalte wirken, wenn sie vorgelesen, durch ein Objektiv betrachtet oder in AR eingeblendet werden. Wenn ein KI-Assistent nicht ohne Bildschirm darauf zugreifen kann, riskieren Sie, komplett übersprungen zu werden.

Und die großen Unternehmen setzen bereits darauf. Google treibt die visuelle Suche mit Lens und Project Astra voran. Amazon macht Alexa hinter den Kulissen schlauer und lässt sie in Ihrem Namen durch Webseiten und Apps wandern. Meta experimentiert mit einer Suche, die über seine Messaging-Apps läuft - z. B. Instagram oder WhatsApp - und bei der Sie Ihre KI direkt in einem Chat-Thread bitten können, ein Restaurant in der Nähe zu finden.

Die Suche wird nicht mehr nur getippt. Sie wird gesprochen, gezeigt und gefühlt. Die Geräte um uns herum - Telefone, Brillen, Wearables - werden still und leise zu den neuen Eingangstüren zur Suche. Weniger Reibung, mehr Fluss.

Hyper-personalisierte Suche: Wenn KI Sie zu gut kennt

Seien wir ehrlich - wie viele Ihrer persönlichen Daten sind Sie wirklich bereit, für intelligentere, "hilfreichere" Suchergebnisse preiszugeben?

Dies ist einer der großen Kompromisse, die sich schnell abzeichnen. Bei der Suche der Zukunft geht es vor allem um Präzision, und diese Präzision hängt davon ab, wie gut die KI Sie kennt. Es geht nicht mehr nur darum, den Standort zu bestimmen oder sich die letzten Suchanfragen zu merken. Jetzt erstellen Suchmaschinen vollständige Benutzerprofile - anhand Ihrer Vorlieben, Ihres Verhaltens, früherer Chats und sogar Ihres Posteingangs - um Antworten zu generieren, die sich anfühlen, als wären sie nur für Sie geschrieben worden.

Und niemand ist in einer besseren Position als Google, um dies zu tun. Mit jahrelangen Daten aus der Suche, Gmail, Maps, YouTube und Android weiß Google bereits mehr über Ihr digitales Leben, als die meisten Menschen zugeben möchten. Und trotz des Drucks der Regulierungsbehörden gibt es keine Anzeichen dafür, dass sich dieser Griff in nächster Zeit lockert.

Dieses Maß an Personalisierung verändert die Art und Weise, wie Abfragen funktionieren. Fragen Sie etwas Einfaches wie "Was soll ich zum Abendessen kochen?" - und die künstliche Intelligenz könnte sich daran erinnern, dass Sie letzte Woche BBQ-Rezepte gegessen, einem Pitmaster aus Kansas City auf YouTube zugeschaut und eine Fünf-Sterne-Bewertung für eine scharfe Sauce hinterlassen haben. Statt allgemeiner Vorschläge könnte die KI eine pflanzliche Version eines Gerichts empfehlen, das Sie wahrscheinlich lieben würden, und zwar aus einem Video, von dem sie bereits weiß, dass Sie es sich ansehen werden.

Bequem? Auf jeden Fall. Unheimlich? Kommt darauf an, wen Sie fragen.

Diese Art der Hyperpersonalisierung ist kein Nebeneffekt - sie ist das Ziel. Googles Project Astra zum Beispiel ist darauf ausgelegt, Ihre Gewohnheiten, Vorlieben und früheren Entscheidungen zu erlernen, damit es die Antworten auf das abstimmen kann, was für Sie wirklich wichtig ist. Es merkt sich, ob Sie bestimmte Ernährungsgewohnheiten haben, ob Sie bestimmte Marken bevorzugen oder ob Sie bereits Interesse an einem Produkt gezeigt haben. Sie erhalten nicht einfach nur ein Suchergebnis - Sie erhalten eine Antwort, die Ihrem Stil entspricht.

Wer baut das sonst noch?

Auch OpenAI ist in diesem Bereich sehr aktiv. Seit 2024 verwendet ChatGPT benutzerdefinierte Anweisungen und Speicher, um sich im Laufe der Zeit an einzelne Nutzer anzupassen. Es nimmt auf:

- Ihr Ton und Ihre Ausdrucksweise.

- Bevorzugte Themen.

- Die Art, wie Sie schreiben.

Wenn also zwei Personen die gleiche Frage stellen, können sie sehr unterschiedliche Antworten erhalten. Wenn Sie zum Beispiel bei der Recherche nach CRMs eine Vorliebe für Open-Source-Tools gezeigt haben, merkt sich ChatGPT das und filtert zukünftige Suchergebnisse entsprechend. Es ist weniger wie die Abfrage einer Datenbank, sondern eher wie die Konsultation eines Forschungsassistenten, der Ihr Playbook kennt.

Alexa+ von Amazon verfolgt die gleiche Idee für zu Hause. Es erinnert sich:

- Kaufhistorie.

- Musikgeschmack.

- Nachrichtenquellen.

- Sogar Familiengeburtstage (wenn Sie sie erzählt haben).

Angenommen, Sie fragen nach einer Idee für ein Familienessen: Alexa wird nicht einfach irgendwelche Rezepte vorschlagen. Sie berücksichtigt die vegetarische Ernährung Ihrer Tochter und die Glutensensibilität Ihres Partners und schlägt etwas vor, das wirklich jeder essen kann. Die Suchergebnisse werden immer mehr zu maßgeschneiderten Aktionen - ein persönlicher Concierge, der immer auf dem Laufenden ist.

Meta sitzt derweil auf einem riesigen Pool an persönlichen Daten aus seinen Plattformen - und beginnt, diese Daten zu nutzen. Berichten zufolge bauen sie eine KI-gestützte Suchmaschine, die direkt in ihr Ökosystem integriert wird. Das bedeutet:

- Wenn Sie WhatsApp oder Instagram nutzen, könnte Metas KI Ihren sozialen Graphen, Ihre Surfgewohnheiten und Ihren Engagement-Verlauf abrufen.

- Die Restaurantvorschläge können sich an den Restaurants Ihrer Freunde orientieren.

- Nachrichten könnten auf die Seiten abgestimmt werden, denen Sie folgen.

Es ist die Art von Personalisierung, die sich nahtlos anfühlt, wenn sie funktioniert - aber sie bringt auch Nachteile mit sich. Der Komfort ist enorm. Die Bedenken hinsichtlich des Datenschutzes sind es auch. Dennoch ist dies die Richtung, in die sich die Dinge entwickeln. In naher Zukunft werden die Nutzer nicht nur relevante Antworten erwarten - sie werden Antworten erwarten, die sich anfühlen, als wären sie speziell für sie geschrieben worden.

Für SEOs und Content-Teams bedeutet dies eine Umkehrung des Spielplans. Sie optimieren nicht mehr für einen breiten "Durchschnittsnutzer". Sie versuchen, Inhalte vor einer KI zu platzieren, die alles durch eine persönliche Linse filtert - einen Nutzer nach dem anderen. Das bedeutet, dass Sie Inhalte erstellen müssen, die klar auf Nischenbedürfnisse, spezifische Verhaltensweisen oder klar definierte Personas zugeschnitten sind. Allgemeine Inhalte gehen im Rauschen unter.

Das erhöht auch den Einsatz für das Vertrauen. Wenn die Nutzer Assistenten so tief in ihr persönliches Leben eindringen lassen, müssen Marken dieses Vertrauen auch verdienen. Aber wenn Sie es richtig machen - wenn Ihre Inhalte zum richtigen Zeitpunkt mit dem richtigen Profil übereinstimmen - wird die KI-Suche weniger zu einem Ranking-Spiel und mehr zu einer persönlichen Empfehlungsmaschine. Ein Ergebnis, das nur für sie erstellt wird.

KI-Gedächtnis: Wenn die Suche das Vergessen stoppt

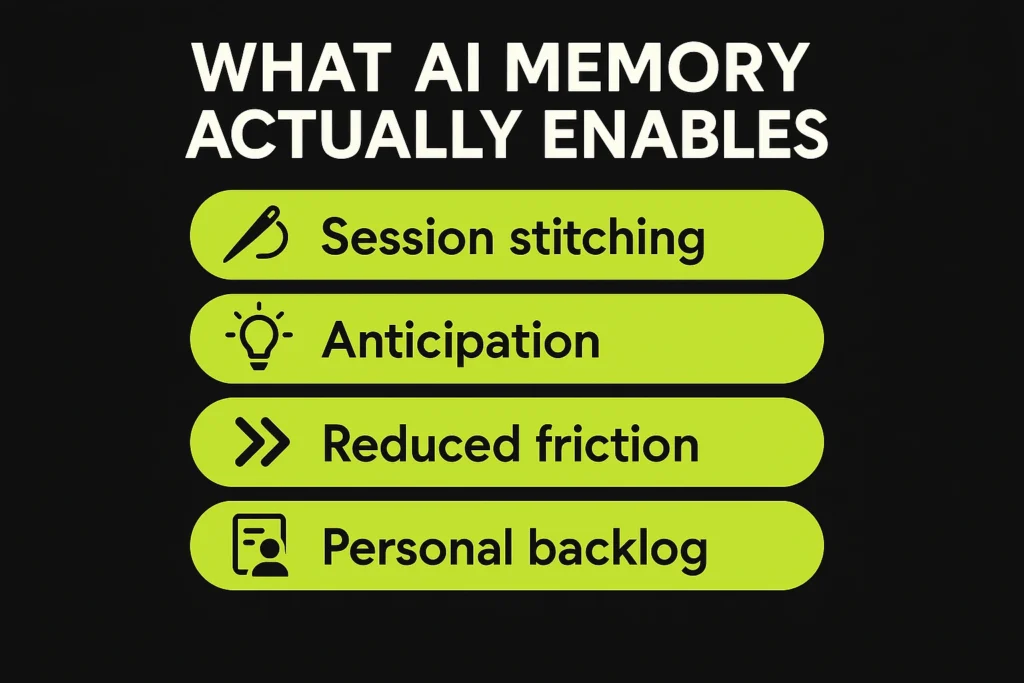

Personalisierung ist nur die eine Hälfte der Geschichte. Die andere Hälfte ist das Gedächtnis - und das wird allmählich zu einem Kernmerkmal der Entwicklung der KI-Suche.

Herkömmliche Suchmaschinen beginnen jedes Mal von neuem. Sie stellen eine Frage, erhalten Ergebnisse, schließen die Registerkarte, und das war's dann. Aber KI-Assistenten funktionieren nicht so. Sie lernen, sich zu erinnern. Künftige KI wird den Kontext nicht nur innerhalb einer Sitzung, sondern über alle Sitzungen hinweg speichern - über alle Geräte hinweg, sogar über Wochen oder Monate hinweg.

Die ersten Anzeichen sind bereits zu erkennen. ChatGPT zum Beispiel kann ein Gespräch führen, das auf sich selbst aufbaut und sich daran erinnert, was Sie vor fünf Eingabeaufforderungen gesagt haben. Aber das ist nur der Kontext auf Sitzungsebene. Was als Nächstes kommt, ist tiefgreifender und langfristiger. Googles Projekt Astra testet bereits diese Art von Kontinuität - ein Gedächtnis, das Ihnen vom Telefon bis zur intelligenten Brille folgt, das sich merkt, was Sie gestern oder letzten Monat gefragt haben, und dieses Wissen in die nächste Interaktion einbringt.

Es ist der Unterschied zwischen einer Frage und einem laufenden Gespräch. Sie könnten sagen: "Was war das für ein thailändisches Restaurant, das ich mir vor ein paar Wochen angesehen habe?", und Ihr Assistent weiß genau, was Sie meinen. Denn er merkt sich, wonach Sie gesucht haben, was Sie ausgelassen haben und was Sie beinahe gebucht hätten. Er ist nicht nur schlau - er passt auch auf.

Was der AI-Speicher tatsächlich ermöglicht

- Session nähen: Persistenter Speicher, der applikations-, geräte- und zeitübergreifend ist.

- Antizipation, nicht Reaktion: KI kann auf der Grundlage früheren Verhaltens handeln, bevor Sie darum bitten.

- Geringere Reibung: Sie müssen sich nicht mehr in verschiedenen Sitzungen oder Anwendungen wiederholen.

- Persönlicher Rückstand Rückruf: KI zeigt frühere Suchen oder übersprungene Ergebnisse an, wenn sie relevant werden.

- Tiefergehende Personalisierung: Empfehlungen, die sich mit Ihren Vorlieben verändern.

- Kontextabhängige Automatisierung: Sie erinnern sich an unerledigte Aufgaben und stupsen Sie später an.

Vom Gedächtnis zur Eigendynamik: Wie KI anfängt zu handeln, wenn sie sich erinnert

Wenn KI sich erinnert, reagiert sie nicht nur, sondern beginnt zu antizipieren. Hier werden die Dinge interessant. Anstatt darauf zu warten, dass Sie etwas fragen, kann sie eingreifen, bevor Sie überhaupt merken, dass Sie Hilfe brauchen.

Amazon deutet diesen Wandel mit Alexa+ bereits an. Es könnte Sie auffordern, früher loszufahren, wenn auf dem Weg zu Ihrem Meeting ein Stau ist, oder Sie darauf hinweisen, dass der Preis der Kopfhörer mit Geräuschunterdrückung, die Sie sich letzte Woche angesehen haben, gerade gesunken ist. Aus der Suche wird eine Unterstützung - und das in Echtzeit.

Google geht in die gleiche Richtung. Sundar Pichai hat eine Vision skizziert, in der KI-Assistenten das Langzeitgedächtnis über Sitzungen, Aufgaben und Geräte hinweg verfolgen. Wenn Sie also eine Reise geplant haben und einen Monat später wiederkommen, um dasselbe Reiseziel für den Frühling zu buchen, braucht Ihr Assistent nicht die ganze Vorgeschichte - er weiß es bereits.

Diese Art von Gedächtnis bedeutet, dass die Benutzer sich nicht ständig wiederholen müssen. Der Assistent macht dort weiter, wo man aufgehört hat - egal, ob es sich um eine Einkaufsanfrage, ein langes Projekt oder die Planung eines Abendessens handelt. So wird die Suche zu etwas Kontinuierlichem - es geht weniger um Antworten im Moment, sondern mehr um das Verständnis im Laufe der Zeit.

Und für Inhaltsteams ändert dieser Wandel die Regeln. Ein Nutzer landet vielleicht einmal auf Ihrer Seite, aber diese Interaktion könnte noch lange nachhallen. Wenn ein KI-Assistent diese Informationen speichert - einen Leitfaden, eine Bewertung, ein Produktdetail -, kann er sie später wieder auftauchen lassen, wenn sie tatsächlich benötigt werden. Nicht, wenn jemand sucht, sondern wenn der Kontext passt.

Damit eröffnet sich eine neue Art von Chance: proaktive Inhalte. Vielleicht hat jemand vor Monaten nach einer Autowartung gefragt - jetzt ist es Zeit für einen Ölwechsel, und die KI liefert eine Erinnerung, zusammen mit einem hilfreichen Ausschnitt von der Website Ihrer Marke. Dieser Moment wurde nicht durch eine Suchanfrage ausgelöst. Er kam aus dem Gedächtnis.

Bei diesem Modell geht es bei der Relevanz nicht nur um Schlüsselwörter, sondern auch um Timing, Kontext und Vertrauen. Wenn Ihre Inhalte es wert sind, dass man sich an sie erinnert, kann die KI sie wieder ins Spiel bringen. Das ist ein ganz anderes Spiel als das, das wir mit den vergesslichen Suchmaschinen von heute gespielt haben.

KI-Systeme zum Sprechen bringen: Warum MCP wichtig ist

Da KI-Assistenten immer komplexere Aufgaben übernehmen, können sie nicht in Silos arbeiten. Sie müssen Daten von verschiedenen Stellen abrufen, externe Tools verwenden und sogar mit anderen KI-Systemen zusammenarbeiten. Hier kommt das Model Context Protocol (MCP) ins Spiel - ein neuer Standard, der verschiedenen KI-Systemen helfen soll, die gleiche Sprache zu sprechen und ihr Wissen auszutauschen.

Betrachten Sie MCP als die Middleware, die KI-Tools synchronisiert. Sie ermöglicht es Assistenten, Live-Kontext aus anderen Apps, Datenbanken oder Content-Systemen zu ziehen - und ihn tatsächlich in Echtzeit zu nutzen. Das ist eine große Sache für alles, was mit der Suche oder der Ausführung von Aufgaben zu tun hat. Anstatt statische, generische Antworten zu geben, könnte eine KI auf die Wissensdatenbank Ihres Unternehmens, Ihre Projektmanagement-Tools oder sogar Ihre internen Dashboards zugreifen, um eine maßgeschneiderte Antwort zu geben.

Von statischen Antworten zur Live-Integration

Das Protokoll selbst wurde von Anthropic eingeführt, um das typische "Walled-Garden"-System zu durchbrechen, in dem die meisten KI-Systeme festsitzen. Normalerweise erfordert die Integration einer KI in Ihre Tools eine individuelle Entwicklung. MCP zielt darauf ab, diesen Prozess zu standardisieren. Mit MCP kann ein Assistent sicher in eine Reihe von Tools eingebunden werden und Kontext über sie hinweg übertragen.

- Begriff: zum Abrufen von Echtzeit-Dokumenten, Besprechungsnotizen oder Produktspezifikationen.

- Jira: um den Status von Problemen, Sprints, Blockern oder den Fortschritt der Bereitstellung zu überprüfen.

- Google Drive: um die neuesten Kalkulationstabellen, Berichte oder Arbeitsentwürfe abzurufen.

- Slack: um die jüngsten Diskussionen im Team oder ungelöste Fragen zu verstehen.

- CRMs oder analytische Dashboards: um Kundendaten, Nutzungsmetriken oder wichtige KPIs abzurufen.

Fragen Sie: "Wie ist der Status von Projekt X?", und anstatt zu raten oder eine vage Antwort zu geben, könnte Ihr Assistent die Notion-, Jira- oder Google Drive-Daten Ihres Teams überprüfen und das aktuelle Update zurückbringen - mit eingebautem Kontext.

Bei MCP geht es nicht um Flash. Es geht um die Infrastruktur - die Art, die KI hinter den Kulissen intelligenter arbeiten lässt. Und für jeden, der suchfähige Inhalte oder assistentengestützte Dienste entwickelt, ist es ein Signal, dass die Zukunft nicht nur in der Sichtbarkeit liegt. Es geht darum, Teil des Ökosystems zu sein, aus dem KI schöpft, wenn sie etwas Zuverlässiges braucht.

Das größere Bild: Kontinuierlicher Kontext und offene Ökosysteme

Was MCP besonders interessant macht, ist nicht nur, dass er Systeme miteinander verbindet - er tut dies in beide Richtungen und merkt sich das. Der Assistent holt sich nicht nur Daten auf Abruf, sondern die angeschlossenen Tools können aktiv Updates zurücksenden. Das gibt der KI einen lebendigen, sich ständig weiterentwickelnden Kontext, in dem sie arbeiten kann.

Stellen Sie sich vor, Sie fragen: "Was soll ich heute tun?" Ihre KI könnte Ihre Termine aus dem Kalender abrufen, das Wetter für Ihren Standort prüfen, eine aktuelle Schlagzeile aus der Branche veröffentlichen - und all das in einer einzigen, personalisierten Antwort zusammenfassen. Diese Art der Synthese wird möglich, weil MCP den Assistenten mit allem verbindet - nicht nur einmal, sondern ständig.

Dieser dynamische Speicher- und Toolzugriff über Systeme hinweg verändert das Sucherlebnis völlig. Sie haben es nicht mehr mit unzusammenhängenden Abfragen und statischen Ergebnissen zu tun. Sie greifen auf einen Assistenten zu, der das Gesamtbild versteht und sich in Echtzeit daran anpasst.

Hier geht es auch um etwas Größeres: Offene Standards wie MCP verhindern, dass wir mit Dutzenden von geschlossenen, isolierten KI-Ökosystemen enden. Das bedeutet, dass Ihr Google-Assistent mit der KI Ihres Autos oder dem internen Bot Ihres Unternehmens kommunizieren könnte und sie alle relevanten Kontext austauschen würden, ohne dass individuelle Integrationen erforderlich wären.

In Zukunft werden wir wahrscheinlich Agenten sehen, die über Netzwerke hinweg delegieren können. Ihre persönliche KI könnte eine juristische Anfrage an einen spezialisierten Recherche-Agenten weiterleiten, auf die Ergebnisse warten und dann die Ergebnisse in eine saubere Zusammenfassung verpacken - ohne dass Sie das jemals manuell koordinieren müssen. An dieser Stelle kommt das A2A-Protokoll (Agent-to-Agent) von Google ins Spiel - dazu kommen wir als Nächstes -, aber der wichtigste Unterschied ist der folgende: Bei MCP geht es um die Verknüpfung von Daten und Tools innerhalb des Arbeitsablaufs eines einzelnen Agenten. Bei A2A geht es um die Zusammenarbeit von Agenten über Grenzen hinweg.

Zusammen ermöglichen sie etwas viel Größeres: eine Welt, in der KI-Agenten nicht nur Fragen beantworten, sondern ganze Aufgaben im Hintergrund orchestrieren, indem sie in Ihrem Namen auf verschiedene Tools und Quellen zurückgreifen.

KI-Agenten, die miteinander sprechen: Das A2A-Protokoll von Google

Um die KI-Assistenten intelligenter und nützlicher zu machen, entwickelt Google ein System, mit dem sie zusammenarbeiten können - nicht nur mit Tools, sondern auch untereinander. Dieses neue Protokoll mit der Bezeichnung A2A (Agent-to-Agent) wird Anfang 2025 als offener Standard eingeführt, der es verschiedenen KI-Agenten ermöglicht, system- und anbieterübergreifend zusammenzuarbeiten.

Während MCP einen Assistenten mit Daten oder Tools verbindet, verknüpft A2A ganze Agenten - selbst wenn sie von verschiedenen Unternehmen entwickelt wurden. Es ist, als würde man ein Expertenteam hinzuziehen, anstatt sich auf einen einzigen Generalisten zu verlassen. Und es bedeutet, dass komplexe Aufgaben aufgeteilt, delegiert und parallel hinter den Kulissen ausgeführt werden können.

Wie A2A funktioniert: Von der Delegation zur Ausführung

In der Praxis sieht das folgendermaßen aus: Angenommen, Sie sagen Ihrer KI: "Planen Sie meinen Wochenendausflug und buchen Sie alles, was ich brauche." Das ist nicht nur eine Aufgabe - es ist eine ganze Kette. Ihr Assistent könnte sich an eine Reisebüro-KI wenden, um Flüge und Hotels zu finden und zu buchen. Gleichzeitig könnte er einen lokalen Restaurantbetreiber anpingen, um eine Reservierung für ein Abendessen zu erhalten. Vielleicht schaltet er sogar einen auf Angebote spezialisierten Agenten ein, um Rabatte zu gewähren. Jeder dieser Agenten arbeitet an seinem Teil, sendet Updates zurück, und Ihr Hauptassistent fügt die Teile zu einer sauberen Reiseroute zusammen.

A2A macht all das möglich, indem es ein gemeinsames Protokoll erstellt. Agenten geben bekannt, was sie tun können, senden und empfangen strukturierte "Aufgaben" und tauschen Kontext oder Ergebnisse - "Artefakte" genannt - auf eine Weise aus, die eine reibungslose Zusammenarbeit ermöglicht.

Es geht nicht nur um eine intelligentere Suche. Es geht um den Aufbau von KI-Ökosystemen, die logisch denken, Arbeitsteilung betreiben und vollständige Lösungen statt isolierter Antworten liefern können. Und das wird schnell gehen.

Googles Vorstoß für A2A macht eines deutlich: Kein einziges KI-Modell wird alles beherrschen. Anstatt zu versuchen, einen Mega-Assistenten zu entwickeln, der alles kann, sieht die Zukunft eher wie ein Netzwerk spezialisierter Agenten aus - jeder erledigt das, was er am besten kann, und arbeitet bei Bedarf zusammen.

A2A und die Zukunft von Suche und Inhalt

Für die Suche ist dies eine entscheidende Neuerung. Komplexe Suchanfragen, die mehrere Aufgaben umfassen, können jetzt aufgeteilt und delegiert werden. Nehmen wir an, Sie fragen: "Helfen Sie mir, ein Haus zu kaufen, den Preis auszuhandeln und das Internet einzurichten." Das sind drei separate Arbeitsabläufe. Mit A2A kann Ihr Hauptassistent eine KI für Immobilienmakler, eine KI für juristische Verträge und eine KI für die Interneteinrichtung einbinden - jede erledigt ihren Teil und gibt dann die Ergebnisse für eine einheitliche Antwort zurück.

Das Protokoll gibt ihnen eine gemeinsame Sprache und Struktur, mit der sie arbeiten können - wie man sich gegenseitig findet, wie man Aktualisierungen übermittelt, wie man Informationen in kompatiblen Formaten zurückgibt. Es ist eine kollaborative Suche, die durch Automatisierung unterstützt wird.

Und das ist nicht nur Theorie. Google hat bereits mehr als 50 Partner - Softwareunternehmen, Start-ups, Plattformen - für die Entwicklung gewonnen. Es wird als offene Initiative von der Linux Foundation verwaltet, was bedeutet, dass es sich nicht um einen ummauerten Garten handelt. Es wird skalierbar aufgebaut.

Bald werden wir Assistenten sehen, die eine Frage wie "Wie kann ich meine Online-Präsenz ausbauen?" aufschlüsseln, indem sie Erkenntnisse von einem Content-Strategie-Agenten, einem SEO-Agenten und einem Webanalyse-Agenten abrufen - jeder mit seinen eigenen Daten, Tools und seiner eigenen Logik - und die Ergebnisse dann zu einer klaren Antwort zusammenfügen. Sie werden die Übergabe nicht sehen. Sie erhalten einfach nur den Einblick.

Das große Ganze? Dies bricht Plattformsilos auf. Ihre Apple-KI könnte eine Anfrage an einen Google- oder OpenAI-Agenten weiterleiten, wenn dies sinnvoll ist - und umgekehrt. Der Assistent in Ihrem Auto könnte Ihren Assistenten zu Hause bitten, etwas auf Ihrem Arbeitscomputer zu überprüfen. All diese Koordination erfolgt über A2A.

Wenn Sie im Marketing oder in der Technik tätig sind, bedeutet das Folgendes: Ihre Inhalte werden nicht mehr nur von Menschen konsumiert. Sie werden von Agenten konsumiert - und diese Agenten brauchen saubere APIs, strukturierte Daten und zugängliche Endpunkte. Wenn Ihr Produkt oder Ihre Inhalte nicht A2A-fähig (oder MCP-fähig) sind, sind sie möglicherweise nicht einmal im Rennen, wenn die KI eine Antwort erstellt.

Das ist SEO, das sich zu etwas Tieferem entwickelt. Es geht weniger um das Ranking, sondern vielmehr darum, nützlich, zugänglich und in großem Umfang maschinenlesbar zu sein.

Die multimodale Suche ist da - und jeder versucht, sie zu nutzen

Alle großen Akteure überdenken die Suche durch die Linse von KI-Assistenten - und die Vision besteht nicht nur aus besseren Antworten. Es geht um Agenten, die handeln, den Kontext verstehen und sich modalitätsübergreifend bewegen.

Google übernimmt die Führung mit einem mehrschichtigen Ansatz. Sein Gemini-Modell treibt alles an, vom KI-Modus bis zu experimentellen Projekten wie Astra und Mariner. Mariner ist besonders aufschlussreich: Es geht nicht mehr nur um die Suche - es geht um Action. Anstatt auf Websites herumzuklicken, können Nutzer jetzt einem Assistenten sagen, dass er Tickets kaufen oder eine Lebensmittelbestellung bearbeiten soll, und der Agent erledigt die Schritte im Hintergrund. Google bezeichnet dies als eine grundlegende Veränderung: Wir suchen nicht mehr auf Websites, sondern delegieren Aufgaben an Agenten.

Im Moment ist Mariner noch in der Testphase mit frühen Nutzern über ein "AI Ultra"-Abonnement, aber es ist auf dem besten Weg, bald in den AI-Modus zu wechseln. Astra hingegen bringt Echtzeit-Intelligenz in die Art und Weise ein, wie Google die Welt versteht - sei es bei der Beantwortung einer Frage zu etwas in Ihrer Kameraansicht oder bei der Verbesserung von Live-Sprach- und Videointeraktionen. Mit Gemini Live und dem bevorstehenden "Agentenmodus" in Chrome wird deutlich, dass Google die Suche zu etwas Immersivem weiterentwickeln möchte, bei dem Fragen, Surfen und Handeln zu einem einzigen, von der KI gesteuerten Fluss verschmelzen.

OpenAI, Microsoft und persistente Agenten

OpenAI, das eng mit Microsoft verbunden ist, geht das gleiche Problem aus einem etwas anderen Blickwinkel an - Konversation zuerst. Der Suchmodus von ChatGPT kombiniert Live-Web-Browsing mit natürlichen Dialogen und Zitaten und verwandelt das Chat-Fenster in eine flüssige, interaktive Suchebene. Aber das ist noch nicht alles.

Mit dem Prototyp des Operator-Agenten entwickelt OpenAI Agenten, die nicht nur Informationen finden, sondern komplette Aufgaben übernehmen. Denken Sie nur: Formulare ausfüllen, Reservierungen vornehmen, Einkäufe abschließen - alles im Hintergrund. Im Jahr 2025 wurden "Agenten" als Kernfunktion eingeführt: KI-Entitäten, die Sie so anpassen können, dass sie in Ihrem Namen handeln. Diese Agenten haben ein Erinnerungsvermögen, verstehen Ihre Stimme oder Marke, greifen auf bestimmte Datensätze zu und führen dauerhafte Workflows aus - auch wenn Sie nicht aktiv mit ihnen in Kontakt sind.

Was diese hartnäckigen Agenten auf den Tisch bringen:

- Ständig aktiver Kontext: Erinnerung an frühere Anfragen, Vorlieben und Stile

- Automatisierte Arbeitsabläufe: Aufgaben, die ohne manuelle Schritt-für-Schritt-Anleitung eingeleitet werden

- Maßgeschneiderte Einblicke: gezielte Vorschläge statt allgemeiner Vorschläge zu machen

Meta, Microsoft, Apple - und die Startup-Wildcards

Meta steht nicht nur am Rande. Im Jahr 2025 hat das Unternehmen unter Zuckerbergs Leitung die Meta Superintelligence Labs ins Leben gerufen - ein hochkarätiges Projekt, das die künstliche Superintelligenz vorantreiben soll. Und sie bemühen sich um die Besten der Branche mit ernsthafter Feuerkraft: milliardenschwere Infrastrukturbudgets, Gehaltsangebote in Höhe von mehreren Millionen Dollar und eine Rekrutierungsliste, die sich wie ein KI-Allstar-Draft liest.

Einige der Namen, die sie an Land gezogen haben? Shengjia Zhao, einer der Köpfe hinter ChatGPT, der jetzt als Chefwissenschaftler fungiert. Dann ist da noch Matt Deitke - gerade einmal 24 Jahre alt und Berichten zufolge mit einem $250-Millionen-Paket eingestellt worden. Insidern zufolge führt Zuckerberg eine wortwörtliche Liste von Top-KI-Forschern, die er haben will - und macht Angebote, die groß genug sind, um die Branche zu erschüttern. Es funktioniert bereits. OpenAI zum Beispiel hat mit aggressiven Bonuszahlungen und Aktienerhöhungen reagiert, um wichtige Mitarbeiter zu halten.

Aber Meta ist nicht allein. Microsoft war durch seine OpenAI-Partnerschaft schon früh im Spiel und hat Bing zu einer KI-zentrierten Suchmaschine gemacht, lange bevor andere nachzogen. Der Chatbot von Bing mit Echtzeit-Antworten und Quellenangaben hat Google wohl zur Einführung von SGE gedrängt. Microsoft integriert Copilot auch in Windows selbst und bettet die Suche direkt in das Betriebssystem ein.

Apple hält sich wie üblich bedeckt, aber Leaks deuten auf wichtige Schritte hin: benutzerdefinierte LLMs, mögliche KI-Suchangebote und eine langfristige Beteiligung an der verkörperten Suche über Hardware wie das Vision Pro Headset.

Und dann gibt es da noch die sich schnell entwickelnden Start-ups - Perplexity, Neeva (jetzt Teil von Snowflake) und andere -, die alle mit KI-gestützter Suche experimentieren, die das herkömmliche Web zugunsten direkter Antworten und zuverlässiger Zusammenfassungen komplett überspringt.

Suche ist keine Funktion mehr - es ist die Schnittstelle

Niemand hat die Zukunft der Suche in der Hand. Aber es ist klar, in welche Richtung sich die Dinge entwickeln: Die Suche wird überall sein, in alles integriert und von Assistenten unterstützt. Ob Googles Task Agents, OpenAIs Konversationslogik, Amazons sprachgesteuerter Handel oder Metas kontextreicher Social Graph - sie alle weisen auf die gleiche Schlussfolgerung hin.

Die Suche ist nicht länger eine statische Liste von Links. Sie wird zu einem lebendigen, kontextbezogenen Dialog. Für Kreative, Marken und Vermarkter ändert sich dadurch das Spiel. Um "gefunden" zu werden, geht es nicht mehr um die Platzierung #1 - es geht darum, die vertrauenswürdige Antwort zu werden, nach der KI greift. Oder das Tool, das sie zur Erfüllung einer Aufgabe auswählt.

Das Suchfeld entwickelt sich zu etwas Größerem - zu einem System, das nicht nur findet, sondern in Ihrem Namen denkt und handelt. Und es ist an der Zeit, mit den Vorbereitungen für diese Zukunft zu beginnen? Sie ist bereits da.

FAQ

Bei GEO - Generative Engine Optimization - geht es darum, Inhalte für die KI-gestützte Entdeckung vorzubereiten, nicht nur für Suchmaschinen. Mit SEO optimieren Sie für traditionelle Web-Rankings. Bei GEO geht es darum, sicherzustellen, dass Ihre Marke, Ihr Produkt oder Ihre Erkenntnisse in den Antworten auftauchen, die KI-Assistenten generieren - sei es per Sprache, Chat oder eingebettet in verschiedene Geräte. Es ist kein Ersatz für SEO, aber es ist definitiv eine Veränderung in der Art und Weise, wie Sichtbarkeit funktioniert.

Nicht ganz - aber es bedeutet, dass Keywords nicht mehr die ganze Geschichte sind. Die KI sucht nicht nur nach exakten Übereinstimmungen. Sie sucht nach Bedeutung, Absicht und Kontext. Keywords sind also nach wie vor wichtig, aber sie müssen in Inhalten enthalten sein, die tatsächlich Fragen beantworten, Probleme lösen und die natürliche Sprache der Menschen widerspiegeln.

Auf jeden Fall - und in gewisser Weise gleicht GEO das Spielfeld aus. KI-Assistenten priorisieren hilfreiche, relevante Inhalte. Wenn Ihre Antwort besser ist, wird sie angezeigt - auch wenn Sie nicht der größte Name in diesem Bereich sind. Um sichtbar zu sein, bedarf es jedoch immer noch einer intelligenten Strukturierung, klarer Signale und zugänglicher Daten. Das ist keine Zauberei.

Strukturierte Daten sind wichtiger denn je. KI-Agenten "lesen" nicht nur wie Menschen - sie analysieren, interpretieren und verknüpfen. Wenn Sie ihnen saubere, strukturierte Inhalte zur Verfügung stellen - sei es durch Schemaauszeichnungen, APIs oder zugängliche Formate -, erhöht sich die Wahrscheinlichkeit, dass Sie ausgewählt, referenziert oder bearbeitet werden.